triangulate

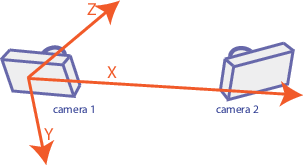

ステレオ イメージでの歪み補正後のマッチする点の 3 次元位置

構文

説明

worldPoints = triangulate(matchedPoints1,matchedPoints2,stereoParams)

worldPoints = triangulate(matchedPoints1,matchedPoints2,camProjection1,camProjection2)

[ はさらに、前述の構文のいずれかの入力引数を使用してワールド ポイントの再投影誤差を返します。worldPoints,reprojectionErrors] = triangulate(___)

[ はさらに、有効および無効なワールド ポイントのインデックスを返します。有効な点はカメラの前に配置されます。worldPoints,reprojectionErrors,validIndex] = triangulate(___)

例

入力引数

出力引数

ヒント

関数 triangulate ではレンズ歪みが考慮されません。点の検出前に関数 undistortImage を使用して、イメージの歪みを補正できます。あるいは、関数 undistortPoints を使用して点自体の歪みを補正できます。

参照

[1] Hartley, Richard, and Andrew Zisserman. Multiple View Geometry in Computer Vision. 2nd ed., 312-313. Cambridge, UK ; New York: Cambridge University Press, 2003.