fitrkernel

ランダムな特徴量拡張を使用してガウス カーネル回帰モデルを当てはめる

構文

説明

fitrkernel は、非線形回帰用のガウス カーネル回帰モデルの学習または交差検証を行います。fitrkernel は、大規模な学習セットが含まれているビッグ データ事例に使用する方が現実的ですが、メモリに収まる小規模なデータ セットにも適用できます。

fitrkernel は、低次元空間のデータを高次元空間にマッピングしてから、正則化された目的関数を最小化することによって高次元空間で線形モデルを当てはめます。高次元空間で線形モデルを取得することは、低次元空間におけるモデルへのガウス カーネルの適用と等価です。使用可能な線形回帰モデルには、正則化されたサポート ベクター マシン (SVM) と最小二乗回帰モデルがあります。

インメモリ データに対して非線形 SVM 回帰モデルに学習をさせる方法については、fitrsvm を参照してください。

Mdl = fitrkernel(Tbl,ResponseVarName)Tbl に含まれる予測子変数と Tbl.ResponseVarName 内の応答値を使用して学習させたカーネル回帰モデル Mdl を返します。

Mdl = fitrkernel(___,Name,Value)

[ は、Mdl,FitInfo,HyperparameterOptimizationResults] = fitrkernel(___)OptimizeHyperparameters が指定されている場合に、ハイパーパラメーターの最適化の結果も返します。

[ は、名前と値の引数 Mdl,FitInfo,AggregateOptimizationResults] = fitrkernel(___)OptimizeHyperparameters と HyperparameterOptimizationOptions が指定されている場合に、ハイパーパラメーターの最適化の結果が格納された AggregateOptimizationResults も返します。HyperparameterOptimizationOptions の ConstraintType オプションと ConstraintBounds オプションも指定する必要があります。この構文を使用すると、交差検証損失ではなくコンパクトなモデル サイズに基づいて最適化したり、オプションは同じでも制約範囲は異なる複数の一連の最適化問題を実行したりできます。

例

SVM を使用して、tall 配列についてカーネル回帰モデルに学習をさせます。

tall 配列に対する計算を実行する場合、MATLAB® は並列プール (Parallel Computing Toolbox™ がある場合は既定) またはローカルの MATLAB セッションを使用します。Parallel Computing Toolbox がある場合にローカルの MATLAB セッションを使用して例を実行するには、関数 mapreducer を使用してグローバルな実行環境を変更します。

mapreducer(0)

データがあるフォルダーの場所を参照するデータストアを作成します。データは、単一のファイル、ファイルの集まり、またはフォルダー全体のどれに含まれていてもかまいません。datastore によって NaN 値に置き換えられるようにするため、'NA' 値を欠損データとして扱います。使用する変数のサブセットを選択します。データストアの先頭に tall table を作成します。

varnames = {'ArrTime','DepTime','ActualElapsedTime'};

ds = datastore('airlinesmall.csv','TreatAsMissing','NA',...

'SelectedVariableNames',varnames);

t = tall(ds);予測子変数 (X) として DepTime と ArrTime を、応答変数 (Y) として ActualElapsedTime を指定します。ArrTime が DepTime より遅い観測値を選択します。

daytime = t.ArrTime>t.DepTime; Y = t.ActualElapsedTime(daytime); % Response data X = t{daytime,{'DepTime' 'ArrTime'}}; % Predictor data

予測子変数を標準化します。

Z = zscore(X); % Standardize the data標準化された予測子を使用して、既定のガウス カーネル回帰モデルに学習をさせます。当てはめの要約を抽出して、最適化アルゴリズムによりモデルがどの程度適切にデータに当てはめられたかを判断します。

[Mdl,FitInfo] = fitrkernel(Z,Y)

Found 6 chunks. |========================================================================= | Solver | Iteration / | Objective | Gradient | Beta relative | | | Data Pass | | magnitude | change | |========================================================================= | INIT | 0 / 1 | 4.307833e+01 | 9.925486e-02 | NaN | | LBFGS | 0 / 2 | 2.782790e+01 | 7.202403e-03 | 9.891473e-01 | | LBFGS | 1 / 3 | 2.781351e+01 | 1.806211e-02 | 3.220672e-03 | | LBFGS | 2 / 4 | 2.777773e+01 | 2.727737e-02 | 9.309939e-03 | | LBFGS | 3 / 5 | 2.768591e+01 | 2.951422e-02 | 2.833343e-02 | | LBFGS | 4 / 6 | 2.755857e+01 | 5.124144e-02 | 7.935278e-02 | | LBFGS | 5 / 7 | 2.738896e+01 | 3.089571e-02 | 4.644920e-02 | | LBFGS | 6 / 8 | 2.716704e+01 | 2.552696e-02 | 8.596406e-02 | | LBFGS | 7 / 9 | 2.696409e+01 | 3.088621e-02 | 1.263589e-01 | | LBFGS | 8 / 10 | 2.676203e+01 | 2.021303e-02 | 1.533927e-01 | | LBFGS | 9 / 11 | 2.660322e+01 | 1.221361e-02 | 1.351968e-01 | | LBFGS | 10 / 12 | 2.645504e+01 | 1.486501e-02 | 1.175476e-01 | | LBFGS | 11 / 13 | 2.631323e+01 | 1.772835e-02 | 1.161909e-01 | | LBFGS | 12 / 14 | 2.625264e+01 | 5.837906e-02 | 1.422851e-01 | | LBFGS | 13 / 15 | 2.619281e+01 | 1.294441e-02 | 2.966283e-02 | | LBFGS | 14 / 16 | 2.618220e+01 | 3.791806e-03 | 9.051274e-03 | | LBFGS | 15 / 17 | 2.617989e+01 | 3.689255e-03 | 6.364132e-03 | | LBFGS | 16 / 18 | 2.617426e+01 | 4.200232e-03 | 1.213026e-02 | | LBFGS | 17 / 19 | 2.615914e+01 | 7.339928e-03 | 2.803348e-02 | | LBFGS | 18 / 20 | 2.620704e+01 | 2.298098e-02 | 1.749830e-01 | |========================================================================= | Solver | Iteration / | Objective | Gradient | Beta relative | | | Data Pass | | magnitude | change | |========================================================================= | LBFGS | 18 / 21 | 2.615554e+01 | 1.164689e-02 | 8.580878e-02 | | LBFGS | 19 / 22 | 2.614367e+01 | 3.395507e-03 | 3.938314e-02 | | LBFGS | 20 / 23 | 2.614090e+01 | 2.349246e-03 | 1.495049e-02 | |========================================================================|

Mdl =

RegressionKernel

ResponseName: 'Y'

Learner: 'svm'

NumExpansionDimensions: 64

KernelScale: 1

Lambda: 8.5385e-06

BoxConstraint: 1

Epsilon: 5.9303

Properties, Methods

FitInfo = struct with fields:

Solver: 'LBFGS-tall'

LossFunction: 'epsiloninsensitive'

Lambda: 8.5385e-06

BetaTolerance: 1.0000e-03

GradientTolerance: 1.0000e-05

ObjectiveValue: 26.1409

GradientMagnitude: 0.0023

RelativeChangeInBeta: 0.0150

FitTime: 13.7601

History: [1×1 struct]

Mdl は RegressionKernel モデルです。回帰誤差を調べるには、Mdl と学習データまたは新しいデータを関数 loss に渡すことができます。または、Mdl と新しい予測子データを関数 predict に渡して、新しい観測値の応答を予測することができます。また、Mdl と学習データを関数 resume に渡して学習を続行することもできます。

FitInfo は、最適化情報が格納されている構造体配列です。最適化終了時の結果が満足できるものであるかどうかを判断するには、FitInfo を使用します。

精度を向上させるため、fitrkernel の名前と値のペアの引数を使用して、最適化反復の最大回数 ('IterationLimit') を増やしたり、許容誤差の値 ('BetaTolerance' および 'GradientTolerance') を小さくしたりすることができます。このようにすると、FitInfo の ObjectiveValue や RelativeChangeInBeta などの尺度が向上します。名前と値のペアの引数 'OptimizeHyperparameters' を使用してモデル パラメーターを最適化することもできます。

carbig データ セットを読み込みます。

load carbig予測子変数 (X) と応答変数 (Y) を指定します。

X = [Acceleration,Cylinders,Displacement,Horsepower,Weight]; Y = MPG;

配列 X および Y から、それぞれの配列で NaN 値が含まれている行を削除します。NaN 値が含まれている行を削除してからデータを fitrkernel に渡すと、学習が高速化され、メモリ使用量が少なくなります。

R = rmmissing([X Y]); % Data with missing entries removed

X = R(:,1:5);

Y = R(:,end); 5 分割の交差検証を使用してカーネル回帰モデルを交差検証します。予測子変数を標準化します。

Mdl = fitrkernel(X,Y,'Kfold',5,'Standardize',true)

Mdl =

RegressionPartitionedKernel

CrossValidatedModel: 'Kernel'

ResponseName: 'Y'

NumObservations: 392

KFold: 5

Partition: [1×1 cvpartition]

ResponseTransform: 'none'

Properties, Methods

numel(Mdl.Trained)

ans = 5

Mdl は RegressionPartitionedKernel モデルです。fitrkernel は 5 分割交差検証を実施するので、学習分割 (分割内) 観測値に対して学習をさせる 5 個の RegressionKernel モデルが Mdl に格納されます。

各分割の交差検証損失 (平均二乗誤差) を調べます。

kfoldLoss(Mdl,'mode','individual')

ans = 5×1

13.1983

14.2686

23.9162

21.0763

24.3975

名前と値の引数 OptimizeHyperparameters を使用して、自動的にハイパーパラメーターを最適化します。

carbig データ セットを読み込みます。

load carbig予測子変数 (X) と応答変数 (Y) を指定します。

X = [Acceleration,Cylinders,Displacement,Horsepower,Weight]; Y = MPG;

配列 X および Y から、それぞれの配列で NaN 値が含まれている行を削除します。NaN 値が含まれている行を削除してからデータを fitrkernel に渡すと、学習が高速化され、メモリ使用量が少なくなります。

R = rmmissing([X Y]); % Data with missing entries removed

X = R(:,1:5);

Y = R(:,end); 自動的なハイパーパラメーター最適化を使用して、5 分割交差検証損失を最小化するハイパーパラメーターを求めます。名前と値の引数 KernelScale、Lambda、Epsilon、および Standardize の最適な値を fitrkernel で求めるため、OptimizeHyperparameters として 'auto' を指定します。再現性を得るために、乱数シードを設定し、'expected-improvement-plus' の獲得関数を使用します。

rng('default') [Mdl,FitInfo,HyperparameterOptimizationResults] = fitrkernel(X,Y,'OptimizeHyperparameters','auto',... 'HyperparameterOptimizationOptions',struct('AcquisitionFunctionName','expected-improvement-plus'))

|===================================================================================================================================|

| Iter | Eval | Objective: | Objective | BestSoFar | BestSoFar | KernelScale | Lambda | Epsilon | Standardize |

| | result | log(1+loss) | runtime | (observed) | (estim.) | | | | |

|===================================================================================================================================|

| 1 | Best | 4.1521 | 0.28206 | 4.1521 | 4.1521 | 11.415 | 0.0017304 | 615.77 | true |

| 2 | Best | 4.1489 | 0.12707 | 4.1489 | 4.1503 | 509.07 | 0.0064454 | 0.048411 | true |

| 3 | Accept | 5.251 | 0.9921 | 4.1489 | 4.1489 | 0.0015621 | 1.8257e-05 | 0.051954 | true |

| 4 | Accept | 4.3329 | 0.11169 | 4.1489 | 4.1489 | 0.0053278 | 2.37 | 17.883 | false |

| 5 | Accept | 4.2414 | 0.11005 | 4.1489 | 4.1489 | 0.004474 | 0.13531 | 14.426 | true |

| 6 | Best | 4.148 | 0.09356 | 4.148 | 4.148 | 0.43562 | 2.5339 | 0.059928 | true |

| 7 | Accept | 4.1521 | 0.069735 | 4.148 | 4.148 | 3.2193 | 0.012683 | 813.56 | false |

| 8 | Best | 3.8438 | 0.096509 | 3.8438 | 3.8439 | 5.7821 | 0.065897 | 2.056 | true |

| 9 | Accept | 4.1305 | 0.082551 | 3.8438 | 3.8439 | 110.96 | 0.42454 | 7.6606 | true |

| 10 | Best | 3.7951 | 0.091029 | 3.7951 | 3.7954 | 1.1595 | 0.054292 | 0.012493 | true |

| 11 | Accept | 4.2311 | 0.40781 | 3.7951 | 3.7954 | 0.0011423 | 0.00015862 | 8.6125 | false |

| 12 | Best | 2.8871 | 0.7843 | 2.8871 | 2.8872 | 185.22 | 2.1981e-05 | 1.0401 | false |

| 13 | Accept | 4.1521 | 0.077822 | 2.8871 | 3.0058 | 993.92 | 2.6036e-06 | 58.773 | false |

| 14 | Best | 2.8648 | 0.76212 | 2.8648 | 2.8765 | 196.57 | 2.2026e-05 | 1.081 | false |

| 15 | Accept | 4.2977 | 0.17285 | 2.8648 | 2.8668 | 0.017949 | 1.5685e-05 | 15.01 | false |

| 16 | Best | 2.8016 | 0.48787 | 2.8016 | 2.8017 | 786 | 3.4462e-06 | 1.6117 | false |

| 17 | Accept | 2.9032 | 0.23285 | 2.8016 | 2.8026 | 974.16 | 0.00019486 | 1.6661 | false |

| 18 | Accept | 2.9051 | 0.92356 | 2.8016 | 2.8018 | 288.21 | 2.6218e-06 | 2.0933 | false |

| 19 | Accept | 3.4438 | 1.3608 | 2.8016 | 2.803 | 56.999 | 2.885e-06 | 1.3903 | false |

| 20 | Accept | 2.8436 | 0.97557 | 2.8016 | 2.8032 | 533.99 | 2.7293e-06 | 0.6719 | false |

|===================================================================================================================================|

| Iter | Eval | Objective: | Objective | BestSoFar | BestSoFar | KernelScale | Lambda | Epsilon | Standardize |

| | result | log(1+loss) | runtime | (observed) | (estim.) | | | | |

|===================================================================================================================================|

| 21 | Accept | 2.8301 | 1.0442 | 2.8016 | 2.8024 | 411.02 | 3.4347e-06 | 0.98949 | false |

| 22 | Accept | 2.8233 | 0.48395 | 2.8016 | 2.8043 | 455.25 | 5.2936e-05 | 1.1189 | false |

| 23 | Accept | 4.1168 | 0.15656 | 2.8016 | 2.802 | 237.02 | 0.85493 | 0.42894 | false |

| 24 | Best | 2.7876 | 0.59307 | 2.7876 | 2.7877 | 495.51 | 1.8049e-05 | 1.9006 | false |

| 25 | Accept | 2.8197 | 0.45478 | 2.7876 | 2.7877 | 927.29 | 1.128e-05 | 1.1902 | false |

| 26 | Accept | 2.8361 | 0.42122 | 2.7876 | 2.7882 | 354.44 | 6.1939e-05 | 2.2591 | false |

| 27 | Accept | 2.7985 | 0.59173 | 2.7876 | 2.7906 | 506.54 | 1.4142e-05 | 1.3659 | false |

| 28 | Accept | 2.8163 | 0.41313 | 2.7876 | 2.7905 | 829.6 | 1.0965e-05 | 2.7415 | false |

| 29 | Accept | 2.8469 | 0.68391 | 2.7876 | 2.7902 | 729.48 | 3.4914e-06 | 0.039087 | false |

| 30 | Accept | 2.882 | 1.267 | 2.7876 | 2.7902 | 255.25 | 3.2869e-06 | 0.059794 | false |

__________________________________________________________

Optimization completed.

MaxObjectiveEvaluations of 30 reached.

Total function evaluations: 30

Total elapsed time: 22.5767 seconds

Total objective function evaluation time: 14.3514

Best observed feasible point:

KernelScale Lambda Epsilon Standardize

___________ __________ _______ ___________

495.51 1.8049e-05 1.9006 false

Observed objective function value = 2.7876

Estimated objective function value = 2.7902

Function evaluation time = 0.59307

Best estimated feasible point (according to models):

KernelScale Lambda Epsilon Standardize

___________ __________ _______ ___________

495.51 1.8049e-05 1.9006 false

Estimated objective function value = 2.7902

Estimated function evaluation time = 0.5625

Mdl =

RegressionKernel

ResponseName: 'Y'

Learner: 'svm'

NumExpansionDimensions: 256

KernelScale: 495.5140

Lambda: 1.8049e-05

BoxConstraint: 141.3376

Epsilon: 1.9006

Properties, Methods

FitInfo = struct with fields:

Solver: 'LBFGS-fast'

LossFunction: 'epsiloninsensitive'

Lambda: 1.8049e-05

BetaTolerance: 1.0000e-04

GradientTolerance: 1.0000e-06

ObjectiveValue: 1.3382

GradientMagnitude: 0.0051

RelativeChangeInBeta: 9.4332e-05

FitTime: 0.0697

History: []

HyperparameterOptimizationResults =

BayesianOptimization with properties:

ObjectiveFcn: @createObjFcn/inMemoryObjFcn

VariableDescriptions: [6×1 optimizableVariable]

Options: [1×1 struct]

MinObjective: 2.7876

XAtMinObjective: [1×4 table]

MinEstimatedObjective: 2.7902

XAtMinEstimatedObjective: [1×4 table]

NumObjectiveEvaluations: 30

TotalElapsedTime: 22.5767

NextPoint: [1×4 table]

XTrace: [30×4 table]

ObjectiveTrace: [30×1 double]

ConstraintsTrace: []

UserDataTrace: {30×1 cell}

ObjectiveEvaluationTimeTrace: [30×1 double]

IterationTimeTrace: [30×1 double]

ErrorTrace: [30×1 double]

FeasibilityTrace: [30×1 logical]

FeasibilityProbabilityTrace: [30×1 double]

IndexOfMinimumTrace: [30×1 double]

ObjectiveMinimumTrace: [30×1 double]

EstimatedObjectiveMinimumTrace: [30×1 double]

ビッグ データの場合、最適化手順に時間がかかる可能性があります。最適化手順を実行するにはデータ セットが大きすぎる場合、データの一部だけを使用してパラメーターの最適化を試すことができます。関数 datasample を使用し、'Replace','false' を指定して、データを非復元抽出します。

入力引数

回帰モデルを当てはめる対象となる予測子データ。n 行 p 列の数値行列を指定します。n は観測値の個数、p は予測子変数の個数です。

Y の長さと X の観測値数は同じでなければなりません。

データ型: single | double

モデルを学習させるために使用する標本データ。table として指定します。Tbl の各行は 1 つの観測値に、各列は 1 つの予測子変数に対応します。オプションとして、Tbl に応答変数用の列を 1 つ追加できます。文字ベクトルの cell 配列ではない cell 配列と複数列の変数は使用できません。

Tblに応答変数が含まれている場合にTbl内の他の変数をすべて予測子として使用するには、ResponseVarNameを使用して応答変数を指定します。Tblに応答変数が含まれている場合にTbl内の他の変数の一部のみを予測子として使用するには、formulaを使用して式を指定します。Tblに応答変数が含まれていない場合は、Yを使用して応答変数を指定します。応答変数の長さとTblの行数は等しくなければなりません。

応答変数および予測子変数サブセットの説明モデル。"Y~x1+x2+x3" という形式の文字ベクトルまたは string スカラーを指定します。この形式では、Y は応答変数を、x1、x2 および x3 は予測子変数を表します。

モデルに学習をさせるための予測子として Tbl 内の変数のサブセットを指定するには、式を使用します。式を指定した場合、formula に現れない Tbl 内の変数は使用されません。

式の変数名は Tbl の変数名 (Tbl.Properties.VariableNames) であり、有効な MATLAB® 識別子でなければなりません。関数 isvarname を使用して Tbl の変数名を検証できます。変数名が有効でない場合、関数 matlab.lang.makeValidName を使用してそれらを変換できます。

データ型: char | string

メモ

ソフトウェアは、NaN、空の文字ベクトル ('')、空の string ("")、<missing>、および <undefined> の要素を欠損値として扱い、以下のいずれかの特性をもつ観測値を削除します。

応答変数の欠損値

予測子の観測値 (

XまたはTblの行) 内の少なくとも 1 つの欠損値重み (

'Weights') がNaN値または0

名前と値の引数

オプションの引数のペアを Name1=Value1,...,NameN=ValueN として指定します。ここで、Name は引数名で、Value は対応する値です。名前と値の引数は他の引数の後に指定しなければなりませんが、ペアの順序は重要ではありません。

例: Mdl = fitrkernel(X,Y,Learner="leastsquares",NumExpansionDimensions=2^15,KernelScale="auto") は、ヒューリスティックな手順により選択されたカーネル スケール パラメーターによる特徴量拡張を使用して、予測子データを 2^15 次元空間にマッピングしてから最小二乗回帰を実施します。

R2021a より前では、名前と値をそれぞれコンマを使って区切り、Name を引用符で囲みます。

例: Mdl = fitrkernel(X,Y,'Learner','leastsquares','NumExpansionDimensions',2^15,'KernelScale','auto')

メモ

交差検証の名前と値の引数は、名前と値の引数 OptimizeHyperparameters と一緒には使用できません。OptimizeHyperparameters の場合の交差検証は、名前と値の引数 HyperparameterOptimizationOptions を使用することのみによって変更できます。

カーネル回帰のオプション

ボックス制約。'BoxConstraint' と正のスカラーで構成されるコンマ区切りペアとして指定します。

この引数は、'Learner' が 'svm' (既定値) であり、正則化項の強度 'Lambda' の値を指定しなかった場合のみ有効です。ボックス制約 (C) と正則化項の強度 (λ) には C = 1/(λn) という関係があるので、'BoxConstraint' または 'Lambda' のいずれかを指定できます。n は観測値 (X の行) の個数です。

例: 'BoxConstraint',100

データ型: single | double

イプシロン不感応区間の幅の半分。'Epsilon' と 'auto' または非負のスカラー値から構成されるコンマ区切りのペアとして指定します。

'auto' の場合、関数 fitrkernel は Epsilon の値を iqr(Y)/13.49 に決定します。これは、応答変数 Y の四分位数間範囲を使用した標準偏差の 1/10 の推定値です。iqr(Y) がゼロに等しい場合、fitrkernel は Epsilon の値を 0.1 に設定します。

'Epsilon' は、Learner が svm である場合のみ有効です。

例: 'Epsilon',0.3

データ型: single | double

拡張空間の次元数。'NumExpansionDimensions' と 'auto' または正の整数から構成されるコンマ区切りのペアとして指定します。'auto' の場合、関数 fitrkernel は 2.^ceil(min(log2(p)+5,15)) を使用して次元数を選択します。p は予測子の個数です。

例: 'NumExpansionDimensions',2^15

データ型: char | string | single | double

カーネル スケール パラメーター。'KernelScale' と 'auto' または正のスカラーから構成されるコンマ区切りのペアとして指定します。MATLAB は、このカーネル スケール パラメーターを使用して、ランダムな特徴量拡張のためのランダムな基底を取得します。詳細については、ランダムな特徴量拡張を参照してください。

'auto' が指定された場合、MATLAB はヒューリスティック手法を使用して適切なカーネル スケール パラメーターを選択します。このヒューリスティック手法では副標本抽出を使用するので、呼び出すたびに推定値が変化する可能性があります。このため、結果を再現するには、学習の前に rng を使用して乱数シードを設定します。

例: 'KernelScale','auto'

データ型: char | string | single | double

正則化項の強度。'Lambda' と 'auto' または非負のスカラーから構成されるコンマ区切りのペアとして指定します。

'auto' の場合、Lambda の値は 1/n です。n は観測値の個数です。

Learner が 'svm' の場合、ボックス制約 (C) と正則化項の強度 (λ) には C = 1/(λn) という関係があるので、BoxConstraint または Lambda のいずれかを指定できます。

例: 'Lambda',0.01

データ型: char | string | single | double

線形回帰モデルのタイプ。'Learner' と 'svm' または 'leastsquares' から構成されるコンマ区切りのペアとして指定します。

次の表では です。

x は p 個の予測子変数による観測値 (行ベクトル) です。

は特徴量を拡張するための観測値 (行ベクトル) の変換です。T(x) は の x を高次元空間 () にマッピングします。

β は係数のベクトルです。

b はスカラー バイアスです。

| 値 | アルゴリズム | 応答の範囲 | 損失関数 |

|---|---|---|---|

'leastsquares' | 通常の最小二乗による線形回帰 | y ∊ (-∞,∞) | 平均二乗誤差 (MSE): |

'svm' | サポート ベクター マシン回帰 | 'leastsquares' と同じ | イプシロン不感応: |

例: 'Learner','leastsquares'

R2023b 以降

予測子データを標準化するためのフラグ。数値または logical の 0 (false) または 1 (true) として指定します。Standardize を true に設定すると、各数値予測子変数が対応する列の平均値と標準偏差によってセンタリングおよびスケーリングされます。ソフトウェアは、カテゴリカル予測子を標準化しません。

例: "Standardize",true

データ型: single | double | logical

詳細レベル。'Verbose' と 0 または 1 のいずれかから構成されるコンマ区切りのペアとして指定します。Verbose は、fitrkernel がコマンド ラインに表示する診断情報の量を制御します。

| 値 | 説明 |

|---|---|

0 | fitrkernel は診断情報を表示しません。 |

1 | fitrkernel は、目的関数の値や勾配の大きさなどの診断情報を表示および格納します。診断情報は FitInfo.History に格納されます。 |

例: 'Verbose',1

データ型: single | double

割り当てられたメモリの最大容量 (メガバイト)。'BlockSize' と正のスカラーから構成されるコンマ区切りのペアとして指定します。

変換後の予測子データを保持するために fitrkernel で必要となるメモリが BlockSize の値より多い場合、MATLAB はブロック単位方式を使用します。ブロック単位方式の詳細については、アルゴリズムを参照してください。

例: 'BlockSize',1e4

データ型: single | double

データ変換の再現性を得るための乱数ストリーム。'RandomStream' と乱数ストリーム オブジェクトから構成されるコンマ区切りのペアとして指定します。詳細については、ランダムな特徴量拡張を参照してください。

X 内のデータを高次元空間に変換するために fitrkernel が使用するランダムな基底関数を再現するには、'RandomStream' を使用します。詳細は、RandStream を使用したグローバル ストリームの管理 と 乱数ストリームの作成と管理 を参照してください。

例: 'RandomStream',RandStream('mlfg6331_64')

他の回帰のオプション

カテゴリカル予測子のリスト。次の表のいずれかの値として指定します。

| 値 | 説明 |

|---|---|

| 正の整数のベクトル | ベクトルの各エントリは、対応する予測子がカテゴリカルであることを示すインデックス値です。インデックス値の範囲は 1 ~

|

| logical ベクトル |

|

| 文字行列 | 行列の各行は予測子変数の名前です。名前は PredictorNames のエントリに一致しなくてはなりません。文字行列の各行が同じ長さになるように、名前を余分な空白で埋めてください。 |

| 文字ベクトルの cell 配列または string 配列 | 配列の各要素は予測子変数の名前です。名前は PredictorNames のエントリに一致しなくてはなりません。 |

"all" | すべての予測子がカテゴリカルです。 |

既定では、予測子データが table (Tbl) 内にある場合、fitrkernel は、その変数が logical ベクトル、categorical ベクトル、文字配列、string 配列または文字ベクトルの cell 配列のいずれかである場合に、変数を categorical であると見なします。予測子データが行列 (X) である場合、fitrkernel はすべての予測子が連続的であると見なします。他の予測子をカテゴリカル予測子として指定するには、名前と値の引数 CategoricalPredictors を使用してそれらを指定します。

特定されたカテゴリカル予測子に対して、fitrkernel はカテゴリカル変数に順序が設定されていないか順序が設定されているかに応じて、2 つの異なる方式を使用してダミー変数を作成します。順序付けのないカテゴリカル変数の場合、fitrkernel は、そのカテゴリカル変数の各レベルについて 1 つずつダミー変数を作成します。順序付けされたカテゴリカル変数の場合、fitrkernel は、カテゴリの数よりも 1 つ少ないダミー変数を作成します。詳細については、ダミー変数の自動作成を参照してください。

例: 'CategoricalPredictors','all'

データ型: single | double | logical | char | string | cell

予測子変数名。一意な名前の string 配列または一意な文字ベクトルの cell 配列として指定します。PredictorNames の機能は、学習データの提供方法によって決まります。

XとYを指定した場合、PredictorNamesを使用してX内の予測子変数に名前を割り当てることができます。PredictorNames内の名前の順序は、Xの列の順序に一致しなければなりません。つまり、PredictorNames{1}はX(:,1)の名前、PredictorNames{2}はX(:,2)の名前であり、他も同様です。また、size(X,2)とnumel(PredictorNames)は等しくなければなりません。既定では

PredictorNamesは{'x1','x2',...}です。

Tblを指定する場合、PredictorNamesを使用して学習に使用する予測子変数を選択できます。つまり、fitrkernelは、学習中にPredictorNamesの予測子変数と応答変数のみを使用します。PredictorNamesはTbl.Properties.VariableNamesのサブセットでなければならず、応答変数の名前を含めることはできません。既定では、すべての予測子変数の名前が

PredictorNamesに格納されます。PredictorNamesとformulaの両方ではなく、いずれか一方を使用して学習用の予測子を指定することをお勧めします。

例: "PredictorNames",["SepalLength","SepalWidth","PetalLength","PetalWidth"]

データ型: string | cell

応答変数名。文字ベクトルまたは string スカラーとして指定します。

Yを指定した場合、ResponseNameを使用して応答変数の名前を指定できます。ResponseVarNameまたはformulaを指定した場合、ResponseNameを使用できません。

例: ResponseName="response"

データ型: char | string

生の応答値を変換するための関数。関数ハンドルまたは関数名として指定します。既定の設定は "none" です。これは @(y)y、つまり変換なしを表します。関数ハンドルは、ベクトル (元の応答値) を受け入れて同じサイズのベクトル (変換した応答値) を返さなければなりません。

例: myfunction = @(y)exp(y) を使用して、指数変換を入力ベクトルに適用する関数のハンドルを作成するとします。この場合、応答変換として ResponseTransform=myfunction を指定できます。

データ型: char | string | function_handle

観測値の重み。'Weights' とスカラー値のベクトルまたは Tbl 内の変数の名前から構成されるコンマ区切りのペアとして指定します。ソフトウェアは、X または Tbl の各観測値 (行) に、Weights の対応する値で重みを付けます。Weights の長さは、X または Tbl の行数と等しくなければなりません。

入力データを table Tbl として指定した場合、Weights は数値ベクトルが含まれている Tbl 内の変数の名前にすることができます。この場合、Weights には文字ベクトルまたは string スカラーを指定しなければなりません。たとえば、重みのベクトル W が Tbl.W として格納されている場合、'W' として指定します。それ以外の場合、モデルを学習させるときに、Tbl の列は W を含めてすべて予測子として扱われます。

既定の設定では、Weights は ones(n,1) です。n は X または Tbl の観測値数です。

fitrkernel は合計が 1 になるように重みを正規化します。Inf の重みはサポートされません。

データ型: single | double | char | string

交差検証オプション

交差検証フラグ。'Crossval' と 'on' または 'off' から構成されるコンマ区切りのペアとして指定します。

'on' を指定した場合、10 分割の交差検証が実施されます。

名前と値のペアの引数 CVPartition、Holdout、KFold または Leaveout を使用すると、この交差検証の設定を変更できます。交差検証済みモデルを作成するときに使用できる交差検証の名前と値のペアの引数は、一度に 1 つだけです。

例: 'Crossval','on'

交差検証分割。交差検証のタイプと学習セットおよび検証セットのインデックス付けを指定する cvpartition オブジェクトとして指定します。

交差検証済みモデルの作成で指定できる名前と値の引数は、CVPartition、Holdout、KFold、Leaveout の 4 つのうちのいずれかのみです。

例: cvp = cvpartition(500,KFold=5) を使用して、500 個の観測値に対する 5 分割交差検証について無作為な分割を作成するとします。この場合、CVPartition=cvp を設定して交差検証分割を指定できます。

ホールドアウト検証に使用するデータの比率。範囲 (0,1) のスカラー値として指定します。Holdout=p を指定した場合、以下の手順が実行されます。

p*100% のデータを無作為に選択して検証データとして確保し、残りのデータを使用してモデルに学習をさせる。コンパクトな学習済みモデルを交差検証済みモデルの

Trainedプロパティに格納する。

交差検証済みモデルの作成で指定できる名前と値の引数は、CVPartition、Holdout、KFold、Leaveout の 4 つのうちのいずれかのみです。

例: Holdout=0.1

データ型: double | single

交差検証済みモデルで使用する分割の数。1 より大きい正の整数値として指定します。KFold=k を指定した場合、以下の手順が実行されます。

データを無作為に

k個のセットに分割する。各セットについて、そのセットを検証データとして確保し、他の

k– 1 個のセットを使用してモデルに学習をさせる。k個のコンパクトな学習済みモデルを、交差検証済みモデルのTrainedプロパティに含まれているk行 1 列の cell ベクトルに格納する。

交差検証済みモデルの作成で指定できる名前と値の引数は、CVPartition、Holdout、KFold、Leaveout の 4 つのうちのいずれかのみです。

例: KFold=5

データ型: single | double

Leave-one-out 法の交差検証のフラグ。'Leaveout' と 'on' または 'off' で構成されるコンマ区切りのペアとして指定します。'Leaveout','on' を指定した場合、n 個の観測値 (n は欠損観測値を除外した観測値の個数) のそれぞれについて以下の手順が実行されます。

その観測値を検証データとして確保し、他の n - 1 個の観測値を使用してモデルに学習をさせる。

n 個のコンパクトな学習済みモデルを、交差検証済みモデルの

Trainedプロパティに含まれている n 行 1 列の cell ベクトルのセルに格納する。

交差検証済みモデルの作成に使用できる名前と値のペアの引数は、CVPartition、Holdout、KFold、Leaveout の 4 つのうちのいずれかのみです。

例: 'Leaveout','on'

収束制御

線形係数およびバイアス項 (切片) の相対許容誤差。非負のスカラーとして指定します。

であるとします。これは、最適化反復 t における係数およびバイアス項のベクトルです。 で最適化が終了します。

GradientTolerance も指定した場合、いずれかの終了条件が満たされると最適化が終了します。

例: 'BetaTolerance',1e-6

データ型: single | double

勾配の絶対許容誤差。非負のスカラーとして指定します。

最適化反復 t における係数およびバイアス項に関する目的関数の勾配ベクトルを とします。 で最適化が終了します。

BetaTolerance も指定した場合、いずれかの終了条件が満たされると最適化が終了します。

例: 'GradientTolerance',1e-5

データ型: single | double

ヘッセ近似の履歴バッファーのサイズ。'HessianHistorySize' と正の整数から構成されるコンマ区切りのペアとして指定します。各反復において、fitrkernel は最新の HessianHistorySize 回の反復の統計量を使用してヘッシアンを構成します。

例: 'HessianHistorySize',10

データ型: single | double

最適化反復の最大回数。'IterationLimit' と正の整数から構成されるコンマ区切りのペアとして指定します。

BlockSize で指定されたメモリに変換後のデータが収まる場合、既定値は 1000 です。それ以外の場合、既定値は 100 です。

例: 'IterationLimit',500

データ型: single | double

ハイパーパラメーター最適化オプション

最適化するパラメーター。'OptimizeHyperparameters' と次のいずれかの値から構成されるコンマ区切りのペアとして指定します。

'none'— 最適化を行いません。'auto'—{'KernelScale','Lambda','Epsilon','Standardize'}を使用します。'all'— すべての使用可能パラメーターを最適化します。使用可能パラメーター名の cell 配列。

optimizableVariableオブジェクトのベクトル。通常はhyperparametersの出力です。

最適化では、パラメーターを変化させることにより、fitrkernel の交差検証損失 (誤差) を最小化しようとします。交差検証のタイプおよびその他の最適化の側面を制御するには、名前と値の引数 HyperparameterOptimizationOptions を使用します。HyperparameterOptimizationOptions を使用すると、ConstraintType オプションと ConstraintBounds オプションを設定することにより、交差検証損失の代わりに (コンパクトな) モデル サイズを最適化の目的として使用できます。

メモ

OptimizeHyperparameters の値は、他の名前と値の引数を使用して指定した値より優先されます。たとえば、OptimizeHyperparameters を "auto" に設定すると、fitrkernel は "auto" オプションに対応するハイパーパラメーターを最適化して、ハイパーパラメーターに指定された値を無視します。

fitrkernel では、以下のパラメーターを使用できます。

Epsilon—fitrkernelは、既定では範囲[1e-3,1e2]*iqr(Y)/1.349の対数スケールで、正の値を探索します。KernelScale—fitrkernelは、既定では範囲[1e-3,1e3]の対数スケールで、正の値を探索します。Lambda—fitrkernelは、既定では範囲[1e-3,1e3]/nの対数スケールで、正の値を探索します。nは観測値の個数です。Learner—fitrkernelは'svm'と'leastsquares'で探索します。NumExpansionDimensions—fitrkernelは、既定では範囲[100,10000]の対数スケールで、正の整数を探索します。Standardize—fitrkernelは、trueとfalseで探索します。

既定以外のパラメーターを設定するには、既定以外の値が含まれている optimizableVariable オブジェクトのベクトルを渡します。以下に例を示します。

load carsmall params = hyperparameters('fitrkernel',[Horsepower,Weight],MPG); params(2).Range = [1e-4,1e6];

'OptimizeHyperparameters' の値として params を渡します。

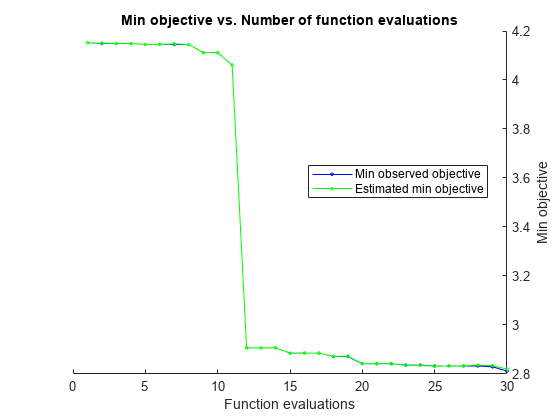

既定では、コマンド ラインに反復表示が表示され、最適化のハイパーパラメーターの個数に従ってプロットが表示されます。最適化とプロットにおける目的関数は、log(1 + cross-validation loss) です。反復表示を制御するには、名前と値の引数 HyperparameterOptimizationOptions の Verbose オプションを設定します。プロットを制御するには、名前と値の引数 HyperparameterOptimizationOptions の ShowPlots オプションを設定します。

たとえば、カーネル回帰の最適化を参照してください。

例: 'OptimizeHyperparameters','auto'

最適化のオプション。HyperparameterOptimizationOptions オブジェクトまたは構造体として指定します。この引数を指定すると、名前と値の引数 OptimizeHyperparameters の効果が変化します。HyperparameterOptimizationOptions を指定する場合、OptimizeHyperparameters も指定しなければなりません。オプションはいずれも任意です。ただし、AggregateOptimizationResults を返すには ConstraintBounds と ConstraintType を設定しなければなりません。構造体で設定できるオプションは HyperparameterOptimizationOptions オブジェクトと同じです。

| オプション | 値 | 既定の設定 |

|---|---|---|

Optimizer |

| "bayesopt" |

ConstraintBounds | N 個の最適化問題の制約範囲。N 行 2 列の数値行列または | [] |

ConstraintTarget | 最適化問題の制約ターゲット。 | ConstraintBounds と ConstraintType を指定する場合の既定値は "matlab" です。そうでない場合、既定値は [] となります。 |

ConstraintType | 最適化問題の制約タイプ。 | [] |

AcquisitionFunctionName | 獲得関数のタイプ:

目的関数の実行時に最適化が決まるので、名前に | "expected-improvement-per-second-plus" |

MaxObjectiveEvaluations | 目的関数評価の最大数。ConstraintBounds を使用して最適化問題を複数指定する場合、MaxObjectiveEvaluations の値は各最適化問題に個別に適用されます。 | "bayesopt" および "randomsearch" の場合は 30、"gridsearch" の場合はグリッド全体 |

MaxTime | 最適化の制限時間。非負の実数スカラーとして指定します。制限時間の単位は、 | Inf |

NumGridDivisions | Optimizer="gridsearch" における各次元の値の個数。値は、各次元の値の個数を表す正の整数のベクトル、またはすべての次元に適用されるスカラーが可能です。カテゴリカル変数の場合、このオプションは無視されます。 | 10 |

ShowPlots | 最適化の進行状況のプロットを表示するかどうかを示す logical 値。このオプションが true の場合、最適な観測された目的関数値が反復回数に対してプロットされます。ベイズ最適化を使用する場合 (Optimizer="bayesopt")、最適な推定された目的関数値もプロットされます。最適な観測された目的関数値および最適な推定された目的関数値は、反復表示の BestSoFar (observed) 列および BestSoFar (estim.) 列の値にそれぞれ対応しています。これらの値は、Mdl.HyperparameterOptimizationResults のプロパティ ObjectiveMinimumTrace および EstimatedObjectiveMinimumTrace で確認できます。問題にベイズ最適化の最適化パラメーターが 1 つまたは 2 つある場合、ShowPlots はパラメーターに対する目的関数のモデルもプロットします。 | true |

SaveIntermediateResults | 最適化の結果を保存するかどうかを示す logical 値。このオプションが true の場合、"BayesoptResults" という名前のワークスペース変数が反復ごとに上書きされます。この変数は BayesianOptimization オブジェクトです。ConstraintBounds を使用して最適化問題を複数指定する場合、ワークスペース変数は "AggregateBayesoptResults" という名前の AggregateBayesianOptimization オブジェクトになります。 | false |

Verbose | コマンド ラインにおける表示レベル:

詳細については、 | 1 |

UseParallel | ベイズ最適化を並列実行するかどうかを示す logical 値。並列実行には Parallel Computing Toolbox™ が必要です。並列でのタイミングに再現性がないため、並列ベイズ最適化で再現性のある結果が生成されるとは限りません。詳細については、並列ベイズ最適化を参照してください。 | false |

Repartition | 反復ごとに交差検証を再分割するかどうかを示す論理値。このオプションが 分割ノイズが考慮されるので、通常は値を | false |

| 次の 3 つのオプションのいずれか 1 つのみを指定してください。 | ||

CVPartition | cvpartition によって作成された cvpartition オブジェクト | 交差検証オプションが指定されていない場合は KFold=5 |

Holdout | ホールドアウトの比率を表す範囲 (0,1) のスカラー | |

KFold | 1 より大きい整数 | |

例: HyperparameterOptimizationOptions=struct(UseParallel=true)

出力引数

学習済みのカーネル回帰モデル。RegressionKernel モデル オブジェクトまたは RegressionPartitionedKernel 交差検証済みモデル オブジェクトとして返されます。

以下の名前と値のペアの引数のうちいずれかが設定されている場合、Mdl は RegressionPartitionedKernel 交差検証済みモデルとなります。CrossVal、CVPartition、Holdout、KFold または Leaveout。それ以外の場合、Mdl は RegressionKernel モデルです。

Mdl のプロパティを参照するには、ドット表記を使用します。たとえば、拡張空間の次元数を表示するには、コマンド ウィンドウで Mdl.NumExpansionDimensions と入力します。

OptimizeHyperparameters を指定して HyperparameterOptimizationOptions の ConstraintType オプションと ConstraintBounds オプションを設定している場合、Mdl はモデル オブジェクトの N 行 1 列の cell 配列になります。ここで、N は ConstraintBounds の行数と等しくなります。いずれの最適化問題からも実行可能なモデルが得られない場合、cell 配列の各値が [] になります。

メモ

他の回帰モデルとは異なり、メモリ消費を節約するため、学習データや学習過程の詳細 (収束履歴など) は RegressionKernel モデル オブジェクトに格納されません。

複数の最適化問題についての最適化の結果の集計。AggregateBayesianOptimization オブジェクトとして返されます。AggregateOptimizationResults を返すには、OptimizeHyperparameters と HyperparameterOptimizationOptions を指定しなければなりません。HyperparameterOptimizationOptions の ConstraintType オプションと ConstraintBounds オプションも指定する必要があります。この出力の生成方法を示す例については、Hyperparameter Optimization with Multiple Constraint Boundsを参照してください。

最適化の詳細。次の表に記載されているフィールドを含む構造体配列として返されます。これらのフィールドには、最終的な値または名前と値のペアの引数の指定が格納されます。

| フィールド | 説明 |

|---|---|

Solver | 目的関数の最小化手法: |

LossFunction | 損失関数。線形回帰モデルのタイプに応じて、平均二乗誤差 (MSE) またはイプシロン不感応になります。Learner を参照してください。 |

Lambda | 正則化項の強度。Lambda を参照してください。 |

BetaTolerance | 線形係数およびバイアス項の相対許容誤差。BetaTolerance を参照してください。 |

GradientTolerance | 勾配の絶対許容誤差。GradientTolerance を参照してください。 |

ObjectiveValue | 最適化終了時の目的関数の値。回帰損失と正則化項を加算することにより目的関数が構成されます。 |

GradientMagnitude | 最適化終了時における目的関数の勾配ベクトルの無限大ノルム。GradientTolerance を参照してください。 |

RelativeChangeInBeta | 最適化終了時の線形係数およびバイアス項の相対的な変化。BetaTolerance を参照してください。 |

FitTime | モデルをデータに当てはめるためにかかった経過実時間 (秒単位)。 |

History | 最適化情報の履歴。このフィールドには Mdl の学習の最適化情報も格納されます。'Verbose',0 を指定した場合、このフィールドは空 ([]) になります。詳細については、Verbose とアルゴリズムを参照してください。 |

フィールドにアクセスするには、ドット表記を使用します。たとえば、各反復における目的関数値のベクトルにアクセスするには、コマンド ウィンドウで FitInfo.ObjectiveValue と入力します。

OptimizeHyperparameters を指定して HyperparameterOptimizationOptions の ConstraintType オプションと ConstraintBounds オプションを設定している場合、Fitinfo は構造体配列の N 行 1 列の cell 配列になります。ここで、N は ConstraintBounds の行数と等しくなります。

FitInfo が提供する情報を確認して、収束が満足できるものであるかどうかを評価します。

ハイパーパラメーターの交差検証最適化。BayesianOptimization オブジェクト、AggregateBayesianOptimization オブジェクト、またはハイパーパラメーターと関連する値の table として返されます。OptimizeHyperparameters の値が "none" 以外であれば、出力は空以外になります。

HyperparameterOptimizationOptions で ConstraintType オプションと ConstraintBounds オプションを設定した場合、HyperparameterOptimizationResults は AggregateBayesianOptimization オブジェクトになります。それ以外の場合、HyperparameterOptimizationResults の値は HyperparameterOptimizationOptions の Optimizer オプションの値によって異なります。

Optimizer オプションの値 | HyperparameterOptimizationResults の値 |

|---|---|

"bayesopt" (既定の設定) | BayesianOptimization クラスのオブジェクト |

"gridsearch" または "randomsearch" | 使用したハイパーパラメーター、観測された目的関数の値 (交差検証損失)、および最低 (最良) から最高 (最悪) までの観測値の順位が格納されている table |

詳細

Random Kitchen Sink[1]や Fastfood[2]などのランダムな特徴量拡張は、ビッグ データに対するカーネル回帰アルゴリズムのガウス カーネルを計算効率が高い方法で近似する手法です。ランダムな特徴量拡張は、大規模な学習セットが含まれているビッグ データ事例に対する方が現実的ですが、メモリに収まる小規模なデータ セットにも適用できます。

カーネル回帰アルゴリズムでは、予測子データを高次元空間にマッピングした後で、各応答データ点 (yi) からの逸脱がイプシロン マージン (ε) の値を超えない最適な関数を求めます。

一部の回帰問題は、線形モデルを使用して適切に表すことはできません。このような場合は、ドット積 x1x2′ を非線形カーネル関数 に置き換えることにより非線形回帰モデルを取得します。ここで、xi は i 番目の観測値 (行ベクトル)、φ(xi) は xi を高次元空間にマッピングする変換 ("カーネル トリック" と呼ばれます) です。しかし、(n が大きい) 大規模なデータ セットでは、観測値の各ペアについて G(x1,x2) (グラム行列) を評価すると計算コストが高くなります。

ランダムな特徴量拡張の方式では、ドット積がガウス カーネルを近似するようなランダム変換を求めます。つまり、次のようになります。

ここで、T(x) は における x を高次元空間 () にマッピングします。Random Kitchen Sink[1]方式では、次のランダムな変換を使用します。

ここで、 は から抽出した標本、σ はカーネル スケールです。この方式では O(mp) の計算および格納が必要です。Fastfood[2]方式では、ガウス スケーリング行列と組み合わせたアダマール行列を使用して、Z の代わりに別のランダムな基底 V を導入します。このランダムな基底により、計算コストが O(mlogp) に、ストレージが O(m) に削減されます。

m および σ の値はそれぞれ、fitrkernel の名前と値のペアの引数 NumExpansionDimensions および KernelScale を使用して指定できます。

関数 fitrkernel は、ランダムな特徴量拡張に Fastfood 方式を使用し、線形回帰を使用してガウス カーネル回帰モデルに学習をさせます。関数 fitrsvm のソルバーでは n 行 n 列のグラム行列の計算が必要ですが、fitrkernel のソルバーに必要なのは、n 行 m 列の行列の形成だけです。ビッグ データの場合は一般に m が n よりはるかに小さくなります。

ボックス制約は、イプシロン マージン (ε) の外部にある観測値に課せられる最大ペナルティを制御するパラメーターであり、過適合の防止 (正則化) に役立ちます。ボックス制約の値を大きくすると、学習時間が長くなる場合があります。

ボックス制約 (C) と正則化項の強度 (λ) には C = 1/(λn) という関係があります。n は観測値の個数です。

ヒント

モデルに学習させる前に予測子を標準化すると役立つことがあります。

関数

normalizeを使用して、学習データを標準化し、テスト データを学習データと同じスケールになるようにスケーリングできます。あるいは、名前と値の引数

Standardizeを使用して学習前に数値予測子を標準化します。返されるモデルのMuプロパティとSigmaプロパティに、予測子の平均と標準偏差がそれぞれ含まれます。 (R2023b 以降)

モデルに学習をさせた後で、新しいデータについて応答を予測する C/C++ コードを生成できます。C/C++ コードの生成には MATLAB Coder™ が必要です。詳細については、コード生成の紹介を参照してください。

アルゴリズム

fitrkernel は、メモリ制限 Broyden-Fletcher-Goldfarb-Shanno (LBFGS) ソルバーとリッジ (L2) 正則化を使用して、正則化された目的関数を最小化します。学習に使用した LBFGS ソルバーのタイプを調べるには、コマンド ウィンドウで FitInfo.Solver と入力します。

'LBFGS-fast'— LBFGS ソルバー。'LBFGS-blockwise'— ブロック単位方式を使用する LBFGS ソルバー。変換後の予測子データを保持するためにfitrkernelで必要となるメモリがBlockSizeの値より多い場合、この関数はブロック単位方式を使用します。'LBFGS-tall'— ブロック単位方式の tall 配列用 LBFGS ソルバー。

fitrkernel がブロック単位方式を使用する場合、各反復で損失と勾配の計算をデータのさまざまな部分に分散させることにより LBFGS が実装されます。また、fitrkernel は、データの一部に対してローカルにモデルを当てはめ、平均化で係数を結合することにより、線形係数およびバイアス項の初期推定値を改善します。'Verbose',1 が指定された場合、fitrkernel は各データ通過についての診断情報を表示し、情報を FitInfo の History フィールドに格納します。

fitrkernel がブロック単位方式を使用しない場合、初期推定値はゼロになります。'Verbose',1 が指定された場合、fitrkernel は各反復についての診断情報を表示し、情報を FitInfo の History フィールドに格納します。

参照

[1] Rahimi, A., and B. Recht. “Random Features for Large-Scale Kernel Machines.” Advances in Neural Information Processing Systems. Vol. 20, 2008, pp. 1177–1184.

[2] Le, Q., T. Sarlós, and A. Smola. “Fastfood — Approximating Kernel Expansions in Loglinear Time.” Proceedings of the 30th International Conference on Machine Learning. Vol. 28, No. 3, 2013, pp. 244–252.

[3] Huang, P. S., H. Avron, T. N. Sainath, V. Sindhwani, and B. Ramabhadran. “Kernel methods match Deep Neural Networks on TIMIT.” 2014 IEEE International Conference on Acoustics, Speech and Signal Processing. 2014, pp. 205–209.

拡張機能

fitrkernel 関数は、tall 配列を次の使用上の注意事項および制限事項付きでサポートします。

fitrkernelは talltableデータをサポートしていません。一部の名前と値のペアの引数は、インメモリの関数

fitrkernelと既定値が異なります。サポートされる名前と値のペアの引数および違いは次のとおりです。'BoxConstraint''Epsilon''NumExpansionDimensions''KernelScale''Lambda''Learner''Verbose'— 既定値は1です。'BlockSize''RandomStream''ResponseTransform''Weights'— 値は tall 配列でなければなりません。'BetaTolerance'— 既定値は1e–3に緩和されます。'GradientTolerance'— 既定値は1e–5に緩和されます。'HessianHistorySize''IterationLimit'— 既定値は20に緩和されます。'OptimizeHyperparameters''HyperparameterOptimizationOptions'— 交差検証として、tall 最適化では'Holdout'検証のみがサポートされます。既定では、データの 20% がホールドアウト検証データとして選択されて確保され、残りのデータがモデルの学習に使用されます。この引数を使用してホールドアウトの比率に別の値を指定できます。たとえば、データの 30% を検証データとして確保するには'HyperparameterOptimizationOptions',struct('Holdout',0.3)と指定します。

'KernelScale'が'auto'である場合、fitrkernelはtallrngによって制御される乱数ストリームをサブサンプリングに使用します。再現性を得るには、tallrngによって制御される乱数ストリームとグローバル ストリームの両方について乱数のシードを設定しなければなりません。'Lambda'が'auto'である場合、fitrkernelはX内の観測値の個数を計算するため、さらにデータを通過する可能性があります。fitrkernelはブロック単位方式を使用します。詳細については、アルゴリズムを参照してください。

詳細は、tall 配列を参照してください。

ハイパーパラメーターの最適化を並列実行するには、fitrkernel 関数を呼び出すときに名前と値の引数 HyperparameterOptimizationOptions で UseParallel=true オプションを使用します。

並列的なハイパーパラメーターの最適化の詳細については、並列ベイズ最適化を参照してください。

並列計算の全般的な情報については、自動並列サポートを使用した MATLAB 関数の実行 (Parallel Computing Toolbox)を参照してください。

fitrkernelは、次の少なくとも 1 つに該当する場合に GPU でモデルを当てはめます。入力引数

XがgpuArrayオブジェクトである。入力引数

YがgpuArrayオブジェクトである。入力引数

TblにgpuArrayの予測子変数または応答変数が含まれている。

詳細は、GPU での MATLAB 関数の実行 (Parallel Computing Toolbox)を参照してください。

バージョン履歴

R2018a で導入fitrkernel は GPU 配列を完全にサポートします。

HyperparameterOptimizationOptions に UseParallel=true が含まれている場合にソフトウェアで並列プールを開けないと、fitrkernel は既定で逐次計算を実行します。

以前のリリースでは、このような状況でソフトウェアからエラーが発行されます。

R2023b 以降では、fitrkernel で数値予測子の標準化がサポートされます。つまり、Standardize の値を true として指定することで、各数値予測子変数を対応する列の平均と標準偏差でセンタリングおよびスケーリングできます。ソフトウェアは、カテゴリカル予測子を標準化しません。

名前と値の引数 OptimizeHyperparameters を使用して Standardize ハイパーパラメーターを最適化することもできます。以前のリリースとは異なり、OptimizeHyperparameters の値として "auto" を指定すると、fitrkernel には最適化可能なハイパーパラメーターとして Standardize が含まれます。

参考

bayesopt | bestPoint | fitrlinear | fitrsvm | loss | predict | RegressionKernel | resume | RegressionPartitionedKernel

MATLAB Command

You clicked a link that corresponds to this MATLAB command:

Run the command by entering it in the MATLAB Command Window. Web browsers do not support MATLAB commands.

Web サイトの選択

Web サイトを選択すると、翻訳されたコンテンツにアクセスし、地域のイベントやサービスを確認できます。現在の位置情報に基づき、次のサイトの選択を推奨します:

また、以下のリストから Web サイトを選択することもできます。

最適なサイトパフォーマンスの取得方法

中国のサイト (中国語または英語) を選択することで、最適なサイトパフォーマンスが得られます。その他の国の MathWorks のサイトは、お客様の地域からのアクセスが最適化されていません。

南北アメリカ

- América Latina (Español)

- Canada (English)

- United States (English)

ヨーロッパ

- Belgium (English)

- Denmark (English)

- Deutschland (Deutsch)

- España (Español)

- Finland (English)

- France (Français)

- Ireland (English)

- Italia (Italiano)

- Luxembourg (English)

- Netherlands (English)

- Norway (English)

- Österreich (Deutsch)

- Portugal (English)

- Sweden (English)

- Switzerland

- United Kingdom (English)