bestPoint

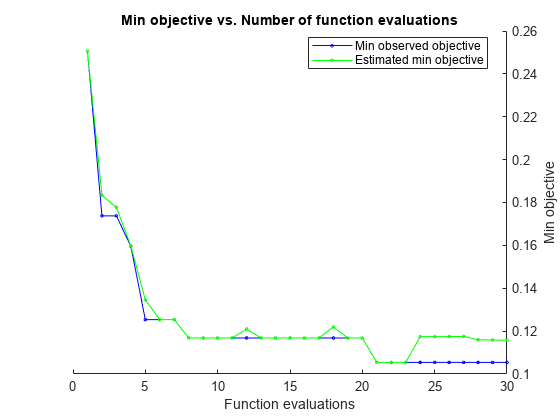

基準に従った、ベイズ最適化における最適点

構文

説明

x = bestPoint(results,Name,Value)

[ は、任意の前の構文において、x,CriterionValue] = bestPoint(___)x における基準の値も返します。

[ は、最適点が返された反復回数も返します。名前と値のペア x,CriterionValue,iteration] = bestPoint(___)Criterion が 'min-observed'、'min-visited-mean'、または既定の 'min-visited-upper-confidence-interval' である場合に適用されます。

例

入力引数

名前と値の引数

出力引数

バージョン履歴

R2016b で導入