DAGNetwork

(非推奨) 深層学習用の有向非循環グラフ (DAG) ネットワーク

説明

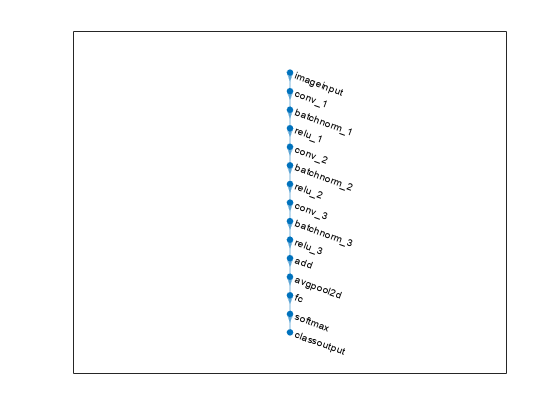

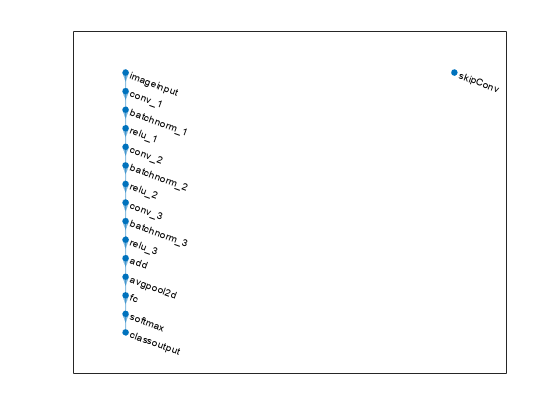

DAG ネットワークは、層が有向非循環グラフとして配置された深層学習用のニューラル ネットワークです。DAG ネットワークは、層に複数の層からの入力および複数の層への出力が含まれる、より複雑なアーキテクチャを持つことができます。

作成

DAGNetwork オブジェクトは、次のようにいくつかの方法で作成できます。

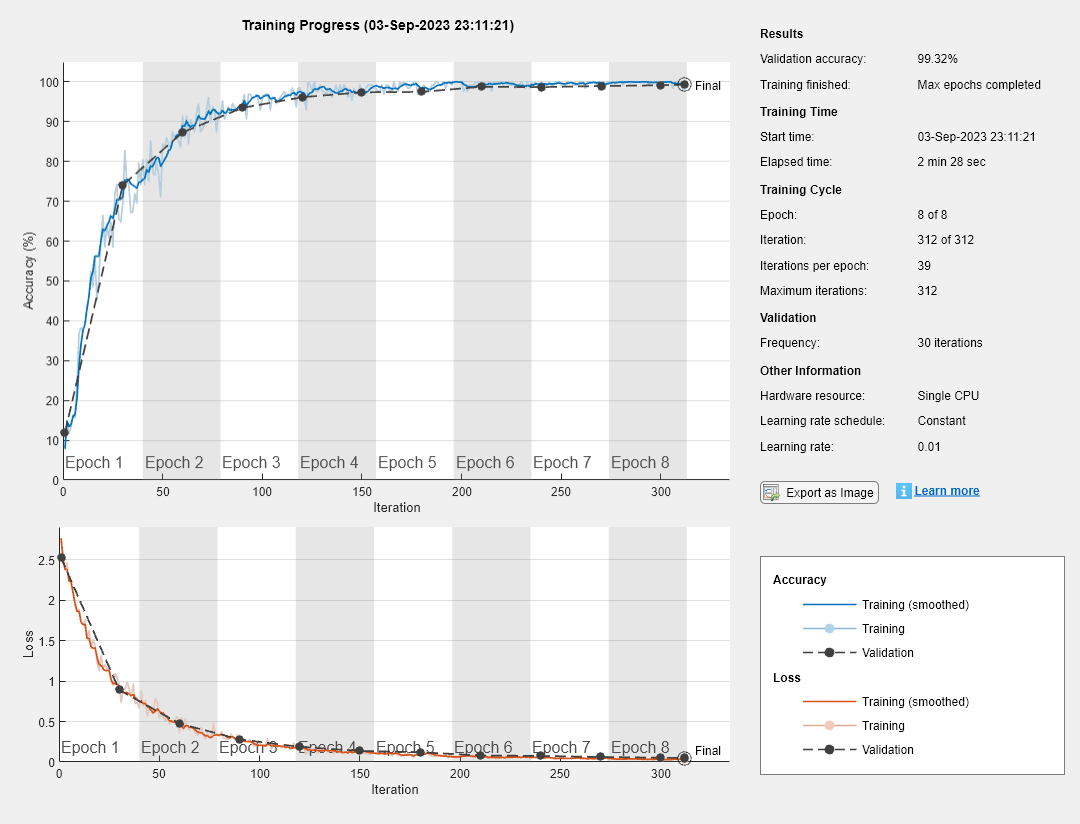

squeezenet、googlenet、resnet50、resnet101、inceptionv3などの事前学習済みのネットワークを読み込みます。例については、SqueezeNet ネットワークの読み込みを参照してください。事前学習済みのネットワークの詳細は、事前学習済みの深層ニューラル ネットワークを参照してください。trainNetworkを使用して、ネットワークの学習または微調整を行う。TensorFlow™-Keras、TensorFlow 2、Caffe、または ONNX™ (Open Neural Network Exchange) のモデル形式から事前学習済みネットワークをインポートする。

Keras モデルの場合は、

importKerasNetworkを使用する。例については、Keras ネットワークのインポートとプロットを参照してください。SavedModel 形式の TensorFlow モデルの場合は、

importTensorFlowNetworkを使用する。例については、TensorFlow ネットワークのイメージ分類用 DAGNetwork としてのインポートを参照してください。Caffe モデルの場合は、

importCaffeNetworkを使用する。例については、Caffe ネットワークのインポートを参照してください。ONNX モデルの場合は、

importONNXNetworkを使用する。例については、ONNX ネットワークの DAGNetwork としてのインポートを参照してください。

関数

assembleNetworkを使用して、事前学習済みの層から深層学習ネットワークを組み立てる。

メモ

他の事前学習済みのネットワークについては、事前学習済みの深層ニューラル ネットワークを参照してください。

プロパティ

オブジェクト関数

activations | (非推奨) 深層学習ネットワーク層の活性化の計算 |

classify | (非推奨) 学習済み深層学習ニューラル ネットワークを使用したデータの分類 |

predict | (非推奨) 学習済み深層学習ニューラル ネットワークを使用した応答の予測 |

plot | ニューラル ネットワーク アーキテクチャのプロット |

predictAndUpdateState | (非推奨) 学習済み再帰型ニューラル ネットワークを使用した応答の予測とネットワーク状態の更新 |

classifyAndUpdateState | (非推奨) 学習済み再帰型ニューラル ネットワークを使用したデータの分類とネットワーク状態の更新 |

resetState | ニューラル ネットワークの状態パラメーターのリセット |