squeezenet

(非推奨) SqueezeNet 畳み込みニューラル ネットワーク

squeezenet は推奨されません。代わりに関数 imagePretrainedNetwork を使用してください。詳細については、バージョン履歴を参照してください。

説明

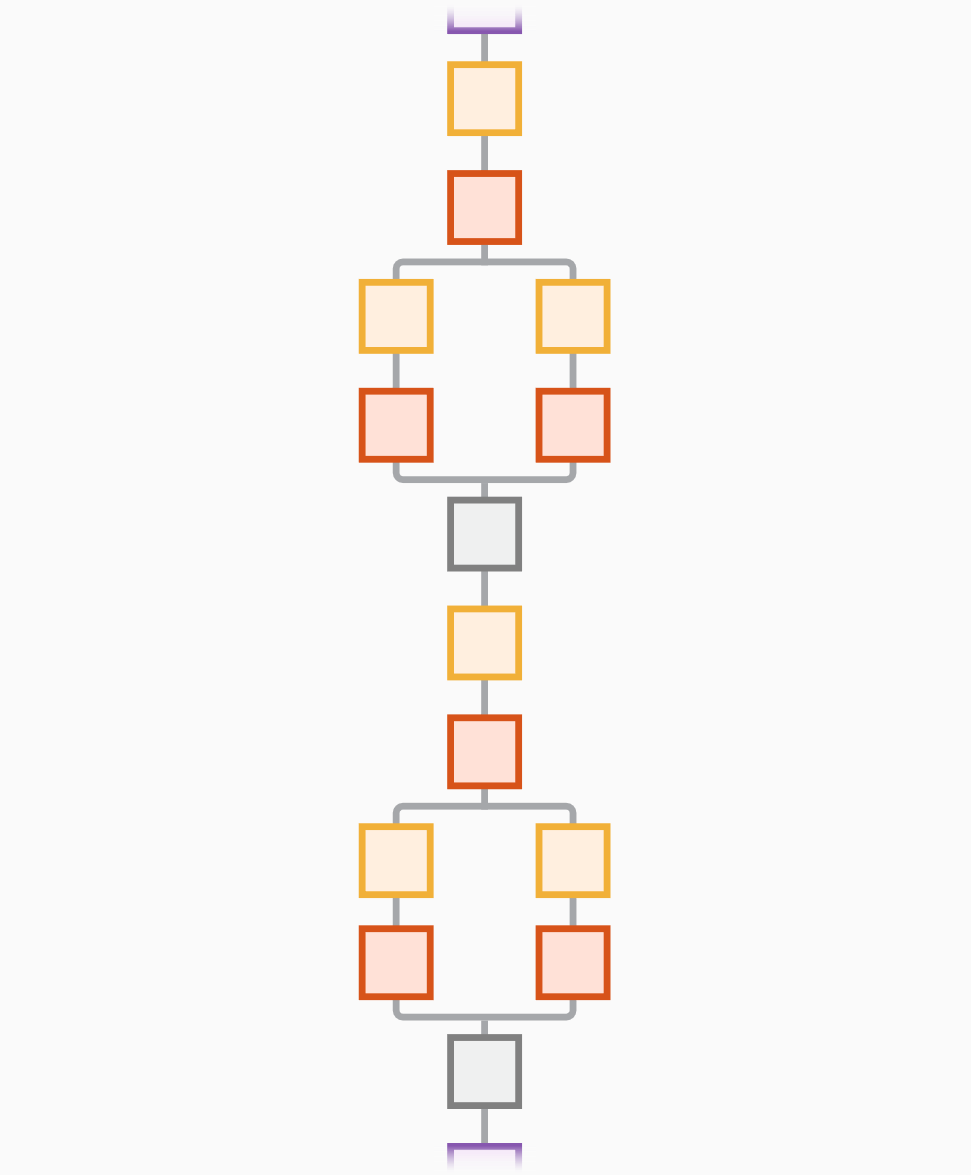

SqueezeNet は、深さが 18 層の畳み込みニューラル ネットワークです。100 万個を超えるイメージで学習させた事前学習済みのネットワークを、ImageNet データベース[1]から読み込むことができます。この事前学習済みのネットワークは、イメージを 1000 個のオブジェクト カテゴリ (キーボード、マウス、鉛筆、多くの動物など) に分類できます。結果として、このネットワークは広範囲のイメージに対する豊富な特徴表現を学習しています。この関数は SqueezeNet v1.1 ネットワークを返します。このネットワークの精度は SqueezeNet v1.0 と同様ですが、予測あたりに必要な浮動小数点演算回数は少なくなります [3]。ネットワークのイメージ入力サイズは 227 x 227 です。MATLAB® の他の事前学習済みのネットワークについては、事前学習済みの深層ニューラル ネットワークを参照してください。

net = squeezenet('Weights','imagenet')net = squeezenet と等価です。

lgraph = squeezenet('Weights','none')

例

出力引数

参照

[1] ImageNet. http://www.image-net.org.

[2] Iandola, Forrest N., Song Han, Matthew W. Moskewicz, Khalid Ashraf, William J. Dally, and Kurt Keutzer. “SqueezeNet: AlexNet-Level Accuracy with 50x Fewer Parameters and <0.5MB Model Size.” Preprint, submitted November 4, 2016. https://arxiv.org/abs/1602.07360.

[3] Iandola, Forrest N. "SqueezeNet." https://github.com/forresti/SqueezeNet.