rcnnObjectDetector

(非推奨) R-CNN 深層学習の検出器を使用したオブジェクトの検出

rcnnObjectDetector は推奨されません。代わりに、yoloxObjectDetector 検出器や yolov4ObjectDetector 検出器といった別のタイプのオブジェクト検出器を使用してください。詳細については、バージョン履歴を参照してください。

説明

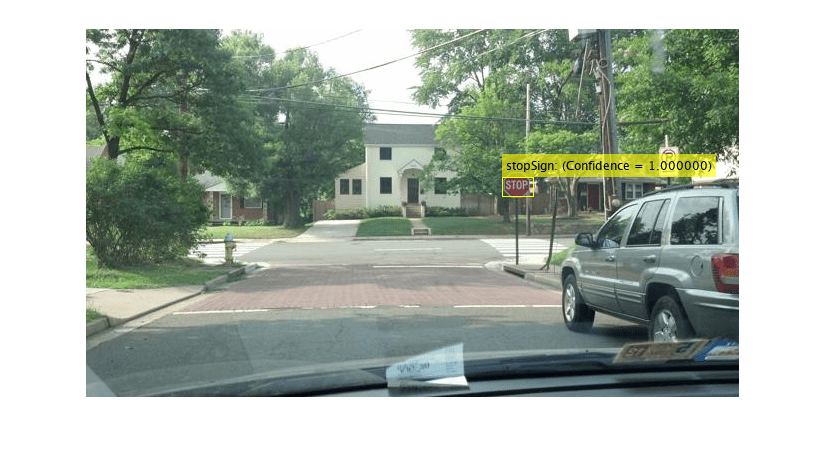

rcnnObjectDetector オブジェクトは、R-CNN (Region-based Convolutional Neural Networks) オブジェクト検出器を使用して、イメージからオブジェクトを検出します。イメージ内のオブジェクトを検出するには、学習済みの検出器を関数 detect に渡します。イメージ領域を分類するには、検出器を関数 classifyRegions に渡します。

rcnnObjectDetector を使用するには、Statistics and Machine Learning Toolbox™ および Deep Learning Toolbox™ が必要です。

rcnnObjectDetector と共に関数 detect または classifyRegions を使用する場合、CUDA® 対応 NVIDIA® GPU の使用が強く推奨されます。この GPU は計算時間を大幅に短縮します。GPU を使用するには、Parallel Computing Toolbox™ が必要です。サポートされる Compute Capability の詳細については、GPU 計算の要件 (Parallel Computing Toolbox)を参照してください。

作成

学習データを指定して関数 trainRCNNObjectDetector を呼び出して、rcnnObjectDetector オブジェクトを作成します (Deep Learning Toolbox が必要)。

detector = trainRCNNObjectDetector(trainingData,...)

プロパティ

オブジェクト関数

detect | (Not recommended) Detect objects using R-CNN deep learning detector |

classifyRegions | (Not recommended) Classify objects in image regions using R-CNN object detector |

例

参照

[1] Girshick, Ross, et al. “Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation.” 2014 IEEE Conference on Computer Vision and Pattern Recognition, IEEE, 2014, pp. 580–87. DOI.org (Crossref), https://doi.org/10.1109/CVPR.2014.81.

[2] Girshick, Ross. “Fast R-CNN.” 2015 IEEE International Conference on Computer Vision (ICCV), IEEE, 2015, pp. 1440–48. DOI.org (Crossref), https://doi.org/10.1109/ICCV.2015.169.