predict

分類木モデルを使用したラベルの予測

構文

説明

例

入力引数

出力引数

詳細

アルゴリズム

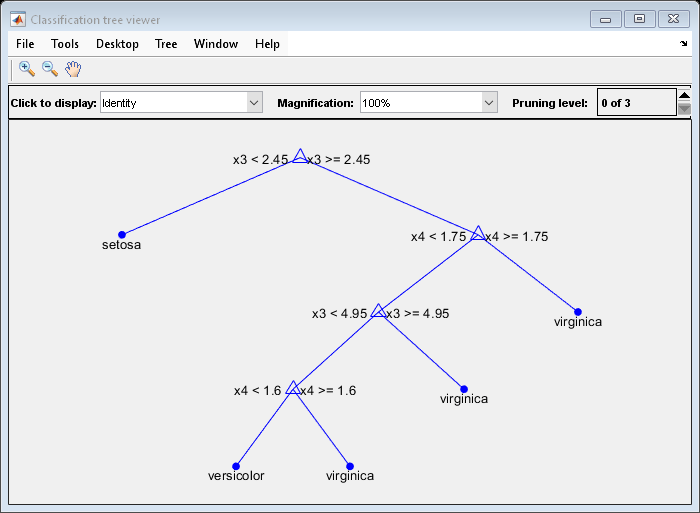

predict は、葉ノードまたは欠損値に達するまで、tree の枝に沿って予測を生成します。predict が、葉ノードに達したら、そのノードの分類が返されます。

predict が予測子の欠損値をもつノードに達した場合の振る舞いは、fitctree で tree を作成したときの名前と値の引数 Surrogate の設定により異なります。

Surrogate="off"(既定値) —predictは、そのノードに達する学習標本の最大数をもつラベルを返します。Surrogate="on"—predictは、そのノードで最適な代理分岐を使用します。正の"関連性予測尺度"を含むすべての代理分岐変数がない場合、predictは、そのノードに達する学習標本の最大数をもつラベルを返します。この定義については、関連性予測尺度を参照してください。

代替機能

Simulink ブロック

Simulink® に分類木モデルの予測を統合するには、Statistics and Machine Learning Toolbox™ ライブラリにある ClassificationTree Predict ブロックを使用するか、MATLAB® Function ブロックを関数 predict と共に使用します。例については、ClassificationTree Predict ブロックの使用によるクラス ラベルの予測とMATLAB Function ブロックの使用によるクラス ラベルの予測を参照してください。

使用するアプローチを判断する際は、以下を考慮してください。

Statistics and Machine Learning Toolbox ライブラリ ブロックを使用する場合、固定小数点ツール (Fixed-Point Designer)を使用して浮動小数点モデルを固定小数点に変換できます。

MATLAB Function ブロックを関数

predictと共に使用する場合は、可変サイズの配列に対するサポートを有効にしなければなりません。MATLAB Function ブロックを使用する場合、予測の前処理や後処理のために、同じ MATLAB Function ブロック内で MATLAB 関数を使用することができます。

拡張機能

バージョン履歴

R2011a で導入

参考

fitctree | compact | prune | loss | edge | margin | CompactClassificationTree | ClassificationTree