vision.PeopleDetector

(削除済み) HOG 特徴を使用した直立の人物の検出

vision.PeopleDetectorpeopleDetectorACF を使用して人物を検出します。

説明

人物検出器オブジェクトは、勾配方向ヒストグラム (HOG) 特徴と学習済みサポート ベクター マシン (SVM) 分類器を使用して、入力イメージ内の人物を検出します。このオブジェクトは、隠れていない、直立姿勢の人物を検出します。

イメージ内の人物を検出するには、次の手順を実行します。

vision.PeopleDetectorオブジェクトを作成し、そのプロパティを設定します。関数と同様に、引数を指定してオブジェクトを呼び出します。

System object の機能の詳細については、System object とはを参照してください。

作成

構文

説明

peopleDetector = vision.PeopleDetectorpeopleDetector を返します。

peopleDetector = vision.PeopleDetector(model)ClassificationModel プロパティを model に設定します。

peopleDetector = vision.PeopleDetector(Name,Value)peopleDetector = vision.PeopleDetector('ClassificationModel','UprightPeople_128x64') です。

プロパティ

使用法

説明

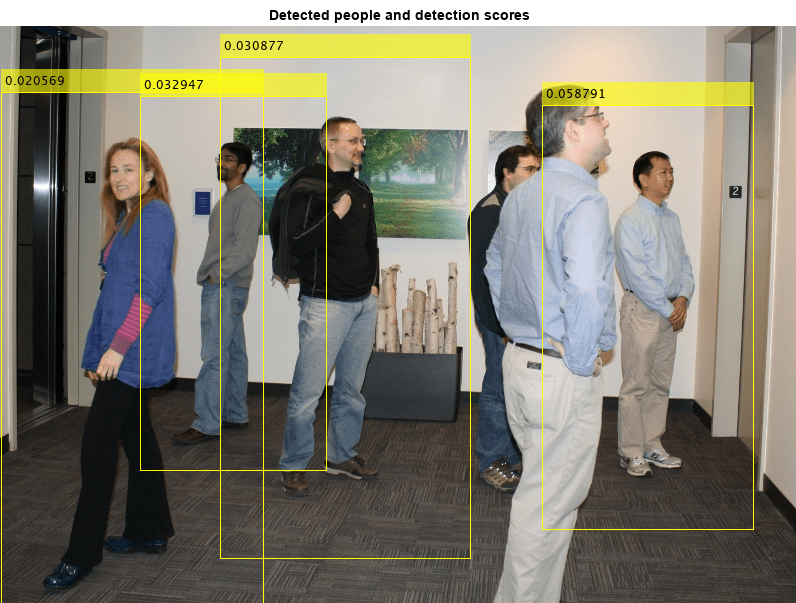

bboxes = peopleDetector(I)I でマルチスケール オブジェクト検出を実行して、M 境界ボックスを定義する M 行 4 列の行列を返します。M は検出された人物の数を表します。出力行列 BBOXES の各行には、4 要素ベクトル [x y width height] が含まれます。このベクトルは、境界ボックスの左上隅とサイズをピクセル単位で指定します。人物が検出されない場合、オブジェクトは空のベクトルを返します。入力イメージ I は、グレースケール イメージまたはトゥルーカラー (RGB) イメージでなければなりません。

[ は、検出の信頼度の値も返します。bboxes, scores] = peopleDetector(I)

入力引数

出力引数

オブジェクト関数

オブジェクト関数を使用するには、System object™ を最初の入力引数として指定します。たとえば、obj という名前の System object のシステム リソースを解放するには、次の構文を使用します。

release(obj)

例

参照

[1] Dalal, N. and B. Triggs. “Histograms of Oriented Gradients for Human Detection,”Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, June 2005, pp. 886-893.