trainBERTDocumentClassifier

構文

説明

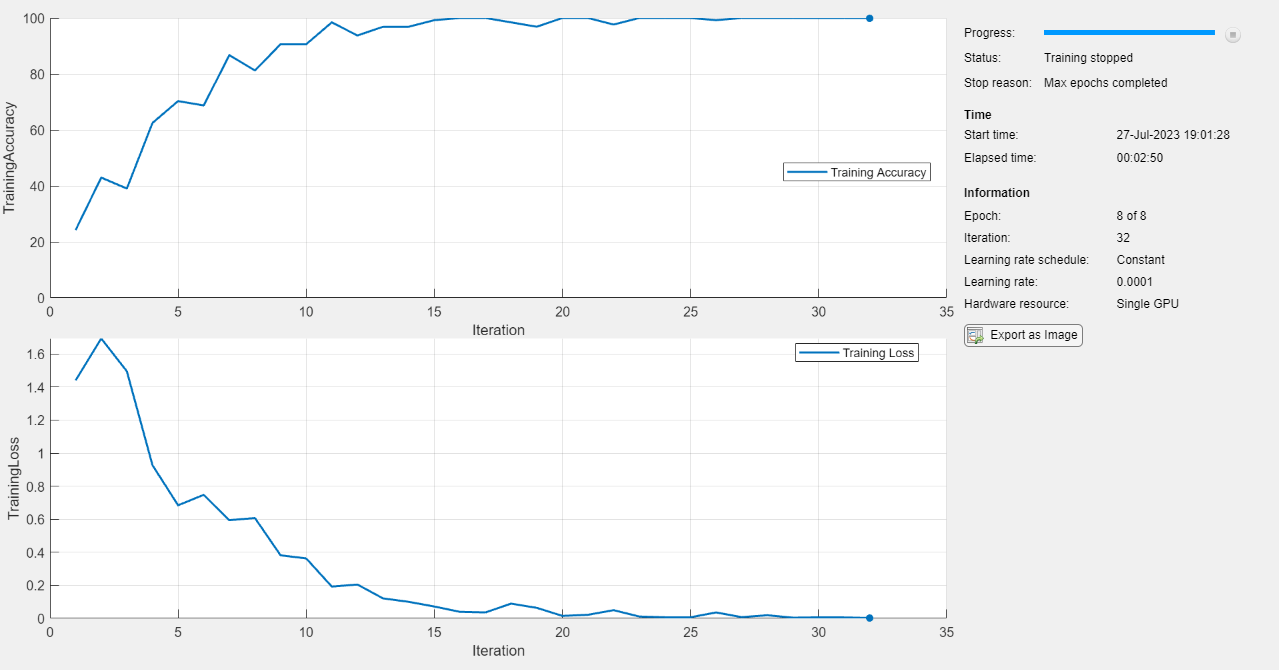

Bidirectional Encoder Representations from Transformer (BERT) モデルは、文書分類やセンチメント分析などの自然言語処理タスクに合わせて微調整できるトランスフォーマー ニューラル ネットワークです。このネットワークは、注意層を使用してコンテキスト内のテキストを解析し、単語間の長距離依存関係を取得します。

mdlTrained = trainBERTDocumentClassifier(documents,targets,mdl,options)

mdlTrained = trainBERTDocumentClassifier(tbl,mdl,options)

例

入力引数

出力引数

参照

[1] Devlin, Jacob, Ming-Wei Chang, Kenton Lee, and Kristina Toutanova. "BERT: Pre-Training of Deep Bidirectional Transformers for Language Understanding" Preprint, submitted May 24, 2019. https://doi.org/10.48550/arXiv.1810.04805.

[2] Srivastava, Nitish, Geoffrey Hinton, Alex Krizhevsky, Ilya Sutskever, and Ruslan Salakhutdinov. "Dropout: A Simple Way to Prevent Neural Networks from Overfitting." The Journal of Machine Learning Research 15, no. 1 (January 1, 2014): 1929–58

[3] Krizhevsky, Alex, Ilya Sutskever, and Geoffrey E. Hinton. "ImageNet Classification with Deep Convolutional Neural Networks." Communications of the ACM 60, no. 6 (May 24, 2017): 84–90. https://doi.org/10.1145/3065386.

バージョン履歴

R2023b で導入