rlMDPEnv

強化学習のためのマルコフ決定過程環境の作成

説明

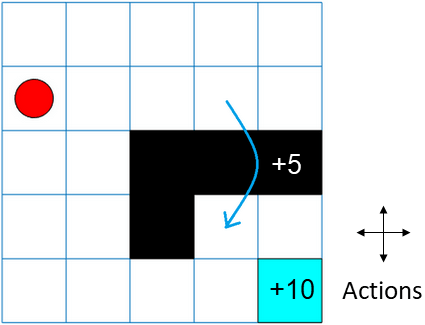

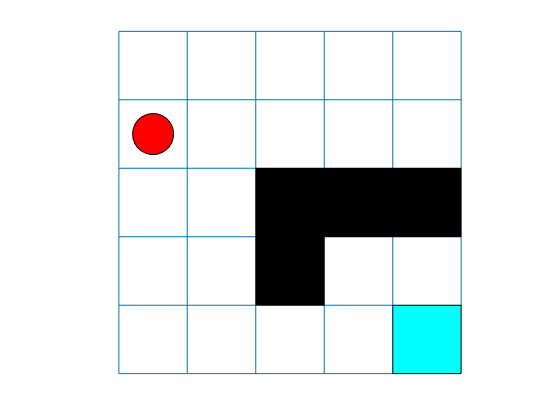

マルコフ決定過程 (MDP) は、状態と観測値が有限空間に属し、確率的ルールが状態遷移を制御する離散時間の確率的制御プロセスです。これは、結果が部分的にランダムであり、部分的に判定者の制御下にある状況での判定をモデル化するための数学的なフレームワークを提供します。MDP は、強化学習を使用して解決された最適化問題を研究するのに役立ちます。rlMDPEnv を使用し、MATLAB® で強化学習のためのマルコフ決定過程環境を作成します。

プロパティ

オブジェクト関数

getActionInfo | Obtain action data specifications from reinforcement learning environment, agent, or experience buffer |

getObservationInfo | Obtain observation data specifications from reinforcement learning environment, agent, or experience buffer |

sim | Simulate trained reinforcement learning agents within specified environment |

train | Train reinforcement learning agents within a specified environment |

validateEnvironment | Validate custom reinforcement learning environment |

例

バージョン履歴

R2019a で導入

参考

関数

createMDP|createGridWorld|rlPredefinedEnv|getObservationInfo|getActionInfo|train|sim|rlCreateEnvTemplate|rlSimulinkEnv|createIntegratedEnv