rlDDPGAgent

深層決定論的方策勾配 (DDPG) 強化学習エージェント

説明

深層決定論的方策勾配 (DDPG) アルゴリズムは、連続行動空間をもつ環境向けの Off-Policy actor-critic 手法です。DDPG エージェントは、決定論的方策を学習すると同時に、Q 値関数クリティックを使用して最適な方策の値を推定します。ターゲット アクターおよびターゲット クリティックに加え、経験バッファーを備えています。DDPG エージェントは、オフライン学習 (環境なしで保存されたデータからの学習) をサポートします。

詳細については、深層決定論的方策勾配 (DDPG) エージェントを参照してください。さまざまな種類の強化学習エージェントの詳細については、強化学習エージェントを参照してください。

作成

構文

説明

観測仕様とアクション仕様からのエージェントの作成

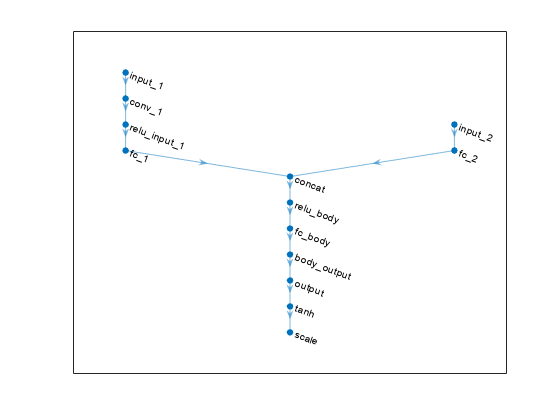

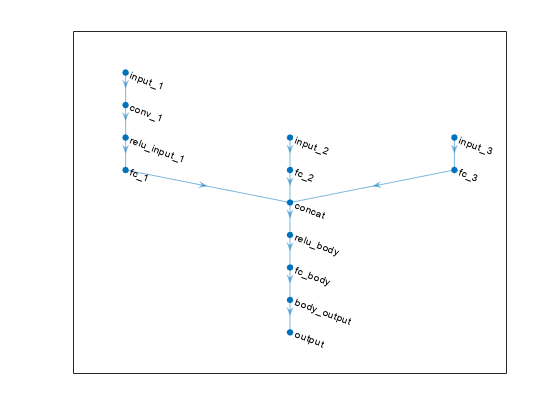

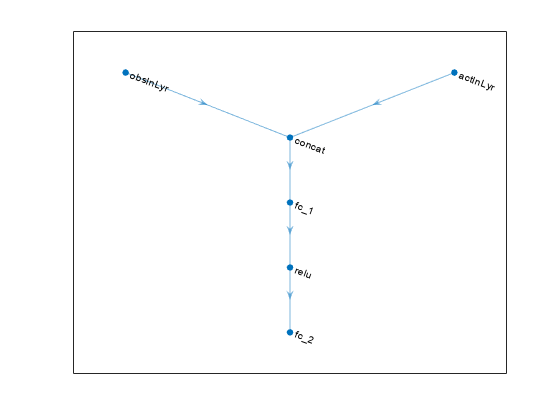

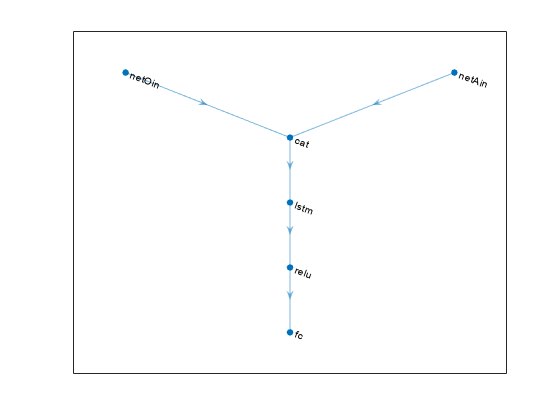

agent = rlDDPGAgent(observationInfo,actionInfo)observationInfo とアクション仕様 actionInfo から構築された既定の深層ニューラル ネットワークを使用します。agent の ObservationInfo プロパティと ActionInfo プロパティは、それぞれ observationInfo 入力引数と actionInfo 入力引数に設定されます。

agent = rlDDPGAgent(observationInfo,actionInfo,initOpts)initOpts オブジェクトで指定されたオプションを使用して構成された既定のネットワークを使用します。初期化オプションの詳細については、rlAgentInitializationOptions を参照してください。

アクターとクリティックからのエージェントの作成

エージェント オプションの指定

agent = rlDDPGAgent(___,agentOptions)AgentOptions プロパティを agentOptions 入力引数に設定します。この構文は、前の構文にある任意の入力引数の後に使用します。

入力引数

プロパティ

オブジェクト関数

train | Train reinforcement learning agents within a specified environment |

sim | Simulate trained reinforcement learning agents within specified environment |

getAction | Obtain action from agent, actor, or policy object given environment observations |

getActor | 強化学習エージェントからのアクターの抽出 |

setActor | Set actor of reinforcement learning agent |

getCritic | 強化学習エージェントからのクリティックの抽出 |

setCritic | Set critic of reinforcement learning agent |

generatePolicyFunction | Generate MATLAB function that evaluates policy of an agent or policy object |

例

バージョン履歴

R2019a で導入