Create a Deep Learning Experiment for Classification

This example shows how to train a deep learning network for classification by using Experiment Manager. In this example, you train two networks to classify images of MathWorks merchandise into five classes. Each network is trained using three algorithms. In each case, a confusion matrix compares the true classes for a set of validation images with the classes predicted by the trained network. For more information on training a network for image classification, see Train Deep Learning Network to Classify New Images.

This experiment requires the Deep Learning Toolbox™ Model for GoogLeNet Network support package. Before you run the experiment, install this support package by calling the googlenet function and clicking the download link.

Open Experiment

First, open the example. Experiment Manager loads a project with a preconfigured experiment that you can inspect and run. To open the experiment, in the Experiment Browser pane, double-click ClassificationExperiment.

Built-in training experiments consist of a description, a table of hyperparameters, a setup function, and a collection of metric functions to evaluate the results of the experiment. For more information, see Train Network Using trainnet and Display Custom Metrics.

The Description field contains a textual description of the experiment. For this example, the description is:

Merchandise image classification using: * an untrained network (default) or a pretrained network (googlenet) * various solvers for training networks (sgdm, rmsprop, or adam)

The Hyperparameters section specifies the strategy and hyperparameter values to use for the experiment. When you run the experiment, Experiment Manager trains the network using every combination of hyperparameter values specified in the hyperparameter table. This example uses two hyperparameters:

Networkspecifies the network to train. The options include"default"(the default network provided by the experiment template for image classification) and"googlenet"(a pretrained GoogLeNet network with modified layers for transfer learning).Solverindicates the algorithm used to train the network. The options include"sgdm"(stochastic gradient descent with momentum),"rmsprop"(root mean square propagation), and"adam"(adaptive moment estimation). For more information about these algorithms, see Algorithms.

The Setup Function section specifies a function that configures the training data, network architecture, and training options for the experiment. To open this function in MATLAB® Editor, click Edit. The code for the function also appears in Setup Function. The input to the setup function is a structure with fields from the hyperparameter table. The function returns three outputs that you use to train a network for image classification problems. In this example, the setup function has these sections:

Load Training Data defines image datastores containing the training and validation data. This example loads images from the file

MerchData.zip. This small data set contains 75 images of MathWorks merchandise, belonging to five different classes. The images are of size 227-by-227-by-3. For more information on this data set, see Image Data Sets.

filename = "MerchData.zip"; dataFolder = fullfile(tempdir,"MerchData"); if ~exist(dataFolder,"dir") unzip(filename,tempdir); end imdsTrain = imageDatastore(dataFolder, ... IncludeSubfolders=true, .... LabelSource="foldernames"); numTrainingFiles = 0.7; [imdsTrain,imdsValidation] = splitEachLabel(imdsTrain,numTrainingFiles);

Define Network Architecture defines the architecture for a convolutional neural network for deep learning classification. In this example, the choice of network to train depends on the value of the hyperparameter

Network.

switch params.Network case "default" inputSize = [227 227 3]; numClasses = 5; layers = [ imageInputLayer(inputSize) convolution2dLayer(5,20) batchNormalizationLayer reluLayer fullyConnectedLayer(numClasses) softmaxLayer classificationLayer]; case "googlenet" inputSize = [224 224 3]; numClasses = 5; imdsTrain = augmentedImageDatastore(inputSize(1:2),imdsTrain); imdsValidation = augmentedImageDatastore(inputSize(1:2), ... imdsValidation); net = googlenet; layers = layerGraph(net); newLearnableLayer = fullyConnectedLayer(numClasses, ... Name="new_fc", ... WeightLearnRateFactor=10, ... BiasLearnRateFactor=10); layers = replaceLayer(layers,"loss3-classifier",newLearnableLayer); newClassLayer = classificationLayer(Name="new_classoutput"); layers = replaceLayer(layers,"output",newClassLayer); otherwise error("Undefined network selection."); end

Specify Training Options defines a

trainingOptionsobject for the experiment. The example trains the network for 8 epochs using the algorithm specified by theSolverentry in the hyperparameter table.

options = trainingOptions(params.Solver, ... MiniBatchSize=10, ... MaxEpochs=8, ... InitialLearnRate=1e-4, ... Shuffle="every-epoch", ... ValidationData=imdsValidation, ... ValidationFrequency=5, ... Verbose=false);

The Metrics section specifies optional functions that evaluate the results of the experiment. This example does not include any custom metric functions.

Run Experiment

When you run the experiment, Experiment Manager trains the network defined by the setup function six times. Each trial uses a different combination of hyperparameter values. By default, Experiment Manager runs one trial at a time. If you have Parallel Computing Toolbox™, you can run multiple trials at the same time or offload your experiment as a batch job in a cluster:

To run one trial of the experiment at a time, on the Experiment Manager toolstrip, set Mode to

Sequentialand click Run.To run multiple trials at the same time, set Mode to

Simultaneousand click Run. If there is no current parallel pool, Experiment Manager starts one using the default cluster profile. Experiment Manager then runs as many simultaneous trials as there are workers in your parallel pool. For best results, before you run your experiment, start a parallel pool with as many workers as GPUs. For more information, see Run Experiments in Parallel and GPU Computing Requirements (Parallel Computing Toolbox).To offload the experiment as a batch job, set Mode to

Batch SequentialorBatch Simultaneous, specify your cluster and pool size, and click Run. For more information, see Offload Experiments as Batch Jobs to a Cluster.

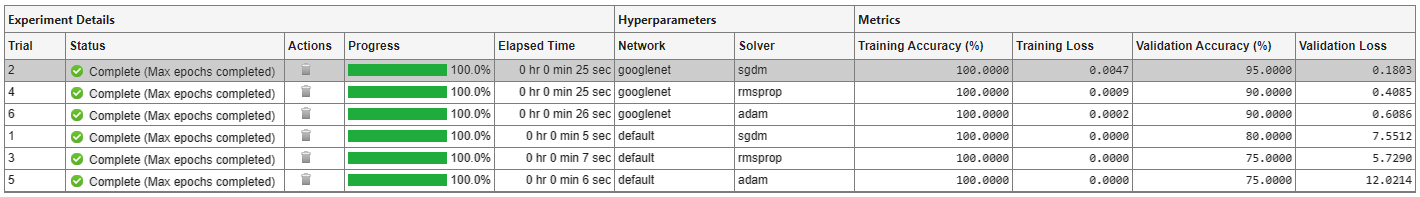

A table of results displays the accuracy and loss for each trial.

To display the training plot and track the progress of each trial while the experiment is running, under Review Results, click Training Plot.

Evaluate Results

To find the best result for your experiment, sort the table of results by validation accuracy:

Point to the Validation Accuracy column.

Click the triangle icon.

Select Sort in Descending Order.

The trial with the highest validation accuracy appears at the top of the results table.

To display the confusion matrix for this trial, select the top row in the results table and, under Review Results, click Validation Data.

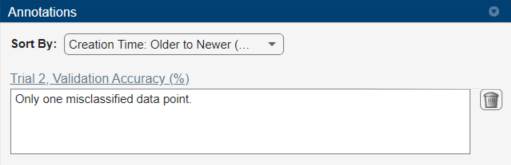

To record observations about the results of your experiment, add an annotation:

In the results table, right-click the Validation Accuracy cell of the best trial.

Select Add Annotation.

In the Annotations pane, enter your observations in the text box.

Close Experiment

In the Experiment Browser pane, right-click MerchandiseClassificationProject and select Close Project. Experiment Manager closes the experiment and results contained in the project.

Setup Function

This function configures the training data, network architecture, and training options for the experiment. The input to this function is a structure with fields from the hyperparameter table. The function returns three outputs that you use to train a network for image classification problems.

function [imdsTrain,layers,options] = ClassificationExperiment_setup(params)

Load Training Data

filename = "MerchData.zip"; dataFolder = fullfile(tempdir,"MerchData"); if ~exist(dataFolder,"dir") unzip(filename,tempdir); end imdsTrain = imageDatastore(dataFolder, ... IncludeSubfolders=true, .... LabelSource="foldernames"); numTrainingFiles = 0.7; [imdsTrain,imdsValidation] = splitEachLabel(imdsTrain,numTrainingFiles);

Define Network Architecture

switch params.Network case "default" inputSize = [227 227 3]; numClasses = 5; layers = [ imageInputLayer(inputSize) convolution2dLayer(5,20) batchNormalizationLayer reluLayer fullyConnectedLayer(numClasses) softmaxLayer classificationLayer]; case "googlenet" inputSize = [224 224 3]; numClasses = 5; imdsTrain = augmentedImageDatastore(inputSize(1:2),imdsTrain); imdsValidation = augmentedImageDatastore(inputSize(1:2), ... imdsValidation); net = googlenet; layers = layerGraph(net); newLearnableLayer = fullyConnectedLayer(numClasses, ... Name="new_fc", ... WeightLearnRateFactor=10, ... BiasLearnRateFactor=10); layers = replaceLayer(layers,"loss3-classifier",newLearnableLayer); newClassLayer = classificationLayer(Name="new_classoutput"); layers = replaceLayer(layers,"output",newClassLayer); otherwise error("Undefined network selection."); end

Specify Training Options

options = trainingOptions(params.Solver, ... MiniBatchSize=10, ... MaxEpochs=8, ... InitialLearnRate=1e-4, ... Shuffle="every-epoch", ... ValidationData=imdsValidation, ... ValidationFrequency=5, ... Verbose=false);

end