quantilePredict

回帰の bag of trees の使用による応答の分位数の予測

構文

説明

YFit = quantilePredict(Mdl,X)Mdl を使用して、予測子データのテーブルまたは行列 X における予測応答の中央値のベクトルを返します。Mdl は TreeBagger モデル オブジェクトでなければなりません。

YFit = quantilePredict(Mdl,X,Name,Value)Name,Value 引数のペアによって指定された追加オプションを使用します。たとえば、分位確率を指定したり分位推定に含める木を指定したりします。

入力引数

名前と値の引数

出力引数

例

詳細

ヒント

quantilePredict は、呼び出されるたびに学習データを使用して応答の条件付き分布を推定します。多数の分位数または多数の観測値についての分位数を効率的に予測するには、観測値の行列またはテーブルとして X を渡し、名前と値のペアの引数 Quantile を使用してベクトルですべての分位数を指定します。つまり、ループ内では quantilePredict を呼び出さないようにします。

アルゴリズム

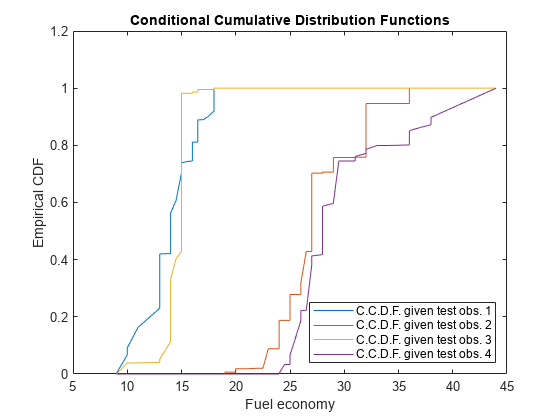

TreeBaggerは、学習データを使用して回帰木のランダム フォレストを成長させます。そして、分位点ランダム フォレストを実装するため、quantilePredictは与えられた予測子変数の観測値に対する応答の経験的な条件付き分布を使用して分位数を予測します。応答の経験的な条件付き分布を取得するため、以下を行います。quantilePredictは、アンサンブル内のすべての木を介してMdl.X内のすべての学習観測値を渡し、学習観測値が属している葉ノードを格納します。quantilePredictは同様に、アンサンブル内のすべての木を介してX内の各観測値を渡します。X内の各観測値について、quantilePredictは以下を行います。各木の応答の重みを計算することにより、応答の条件付き分布を推定します。

X内の観測値 k について、アンサンブル全体に対する条件付き分布を集約します。n は学習観測値の個数 (

size(Y,1))、T はアンサンブル内の木の本数 (Mdl.NumTrees) です。

X内の観測値 k について、τ の分位数、つまり 100τ% の百分位数は になります。

quantilePredictは、すべての指定された重みを以下のようにして使用します。すべての学習観測値 j = 1,...,n およびすべての選択された木 t = 1,...,T について、

quantilePredictは (Mdl.X(とj,:)Mdl.Y(に格納されている) 学習観測値 j に対して積 vtj = btjwj,obs を求めます。btj は、木 t のブートストラップ標本に観測値 j が含まれていた回数です。wj,obs はj)Mdl.W(内の観測値の重みです。j)選択された各木について、

quantilePredictは各学習観測値が属する葉を特定します。観測値 j が属している木 t の葉に含まれているすべての観測値の集合を St(xj) とします。選択された各木について、

quantilePredictは特定の葉に含まれているすべての重みを合計が 1 になるように正規化します。つまり、次のようになります。各学習観測値および木について、

quantilePredictはTreeWeightsで指定された木の重み (wt,tree) を組み込みます。つまり、w*tj,tree = wt,treevtj* を求めます。予測に選択されなかった木の重みは 0 になります。X内のすべての検定観測値 k = 1,...,K および選択されたすべての木 t = 1,...,T について、quantilePredictは観測値が属する一意な葉を予測し、予測した葉に含まれるすべての学習観測値を特定します。quantilePredictは、次のように重み utj を割り当てます。quantilePredictは、選択されたすべての木に対する重みを合計します。つまり、次のようになります。quantilePredictは、合計が 1 になるように重みを正規化することにより、応答の重みを作成します。つまり、次のようになります。

参考文献

[1] Breiman, L. "Random Forests." Machine Learning 45, pp. 5–32, 2001.

[2] Meinshausen, N. “Quantile Regression Forests.” Journal of Machine Learning Research, Vol. 7, 2006, pp. 983–999.

バージョン履歴

R2016b で導入